Какой контент нужен, чтобы бренд попадал в «лучшие/топ» ответы ИИ: доказательства, нейтральность, структура

Когда пользователь спрашивает у ChatGPT или Gemini «какой бренд выбрать» или «топ лучших», модель не «рекламирует» в привычном смысле. Она собирает ответ из того, что выглядит проверяемым, нейтральным и удобно собирается в связное объяснение. Поэтому контент, который попадает в «лучшие/топ» ответы ИИ, чаще похож не на продающую посадочную страницу, а на аккуратно собранную доказательную базу с понятной структурой.

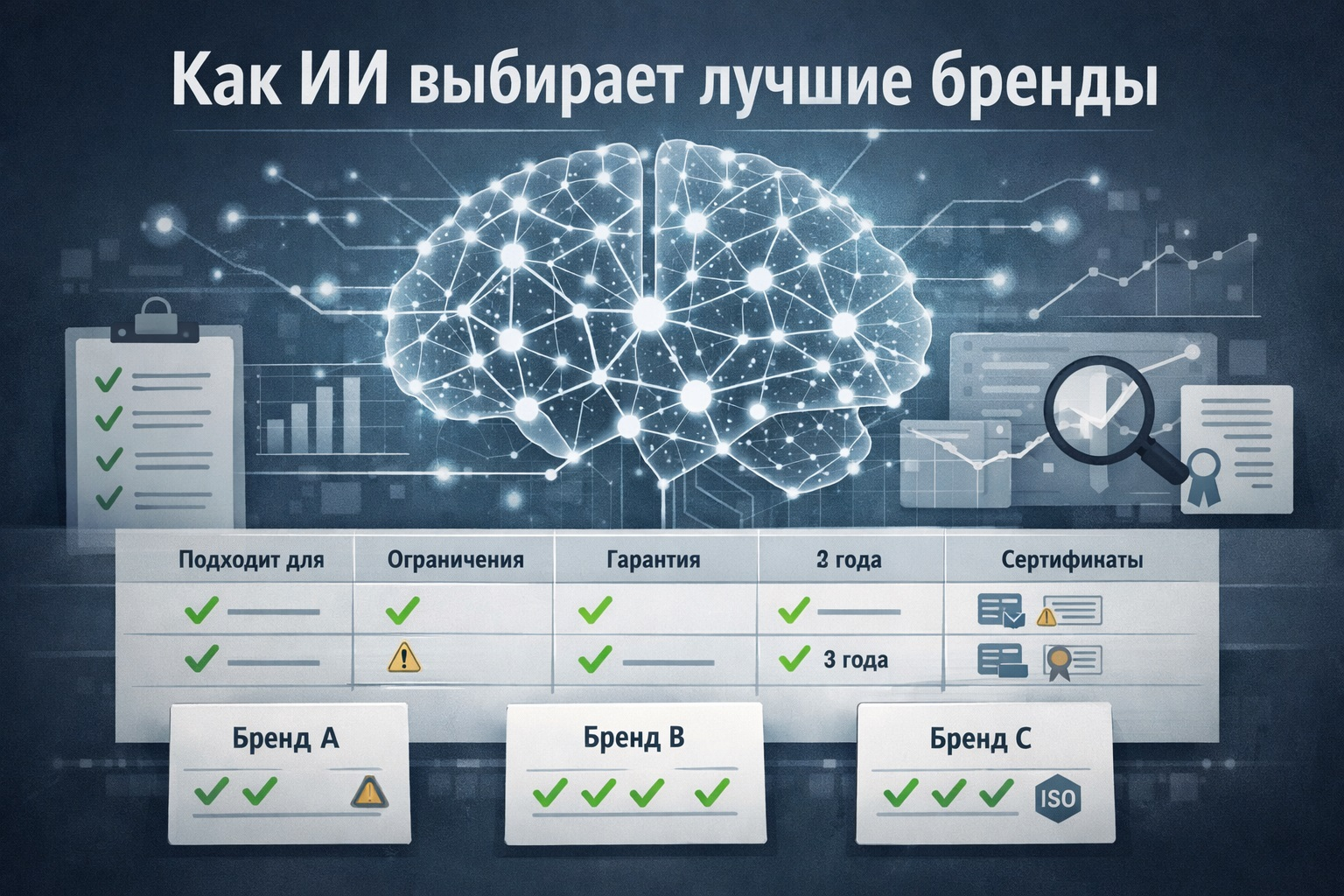

Первый слой — доказательства, которые можно пересказать без натяжек. Для LLM важны факты, которые легко цитировать: измеримые характеристики, стандарты, сертификаты, результаты тестов, методология, условия гарантии, география сервиса, прозрачные цены и ограничения. Чем точнее формулировки и чем меньше «самые-самые», тем выше шанс, что модель выберет ваш фрагмент как опорный. В B2C это особенно заметно: ИИ лучше воспроизводит «подходит для…», «не подходит для…», «срок службы/доставка/совместимость», чем «вдохновляющий» слоган. Работают и независимые источники: упоминания в медиа, рейтинги, исследования, отраслевые награды — но только если рядом есть контекст, по каким критериям они получены.

Второй слой — нейтральность. Парадоксально, но чтобы попасть в «топ», полезно не избегать минусов. Тексты, где есть честные ограничения, выглядят надежнее и проще для безопасного ответа: «да, есть такой компромисс, зато вот это решает задачу». Для CMO это смена привычной оптики: не «закрыть возражение», а «обозначить границы применения». ИИ охотнее рекомендует бренд, если видит, что бренд сам умеет говорить о своем продукте без агрессии и манипуляций. Нейтральный тон + сравнимость = доверие.

Третий слой — структура, удобная для машинного «склеивания». Модели любят, когда материал разложен по сущностям и вопросам: что это, кому подходит, какие варианты, как выбрать, как использовать, какие есть альтернативы, ответы на частые вопросы. На практике это означает: отдельные страницы под ключевые сценарии (выбор, сравнение, руководство, безопасность, возврат), единые названия характеристик, стабильная терминология, отсутствие противоречий между разделами сайта, пресс-материалами и FAQ. Чем меньше разнобоя в формулировках, тем проще модели «собрать» вашу позицию без ошибок.

Отдельный пункт — «топ» как формат. Запросы «лучшие бренды» почти всегда подразумевают критерии. Если вы не помогли рынку сформулировать критерии, критерии сформулируют за вас — и не факт, что в вашу пользу. Поэтому полезен контент, где критерии выбора объяснены спокойно и с примерами, а ваш бренд встраивается в матрицу как один из вариантов для конкретного профиля пользователя. Это не снижает продажность, это повышает уместность. ИИ редко выбирает «единственно верный» вариант, но часто рекомендует 2–5 решений под разные условия — и туда можно стабильно попадать.

Чтобы управлять этим системно, нужен мониторинг: как бренд звучит в разных LLM, в каких сценариях упоминается, кто рядом в рекомендациях, где модель путается или недоговаривает. llmSpot как раз помогает увидеть «видимость в ИИ» в разрезе платформ (ChatGPT, Gemini, Perplexity и др.), сравнить share of voice с конкурентами, найти пробелы в доказательствах и структуре, а затем превратить это в практичный план: какие страницы дописать, какие формулировки унифицировать, какие медиа-каналы и форматы PR дадут больше сигналов для генеративного поиска. Для больших B2C-команд это ещё и способ ускорить коммуникации: меньше споров «что публиковать», больше решений на данных.

Побеждают в «топ-ответах» не те, кто громче, а те, кто понятнее. Если бренд умеет говорить проверяемыми фактами, держит нейтральный тон и дает модели ясные блоки смысла, он становится удобным материалом для ответа — а значит, чаще оказывается в той самой подборке «лучших».