Как проверить работу SEO-специалиста? Статья для особо тревожных заказчиков!

Ранее мы писали о том, как найти хорошего SEO-исполнителя и защитить себя от обмана, но данная тема довольно обширна, и мы решили зайти чуточку дальше — рассказать, как следить за работой специалиста и убедиться в его грамотности. Для особо тревожных расписали подробно данную статью, разделив ее на три основных блока: базовая оптимизация, технические работы и производительность. Не будем долго вдаваться в вступления, перейдем сразу к объяснениям.

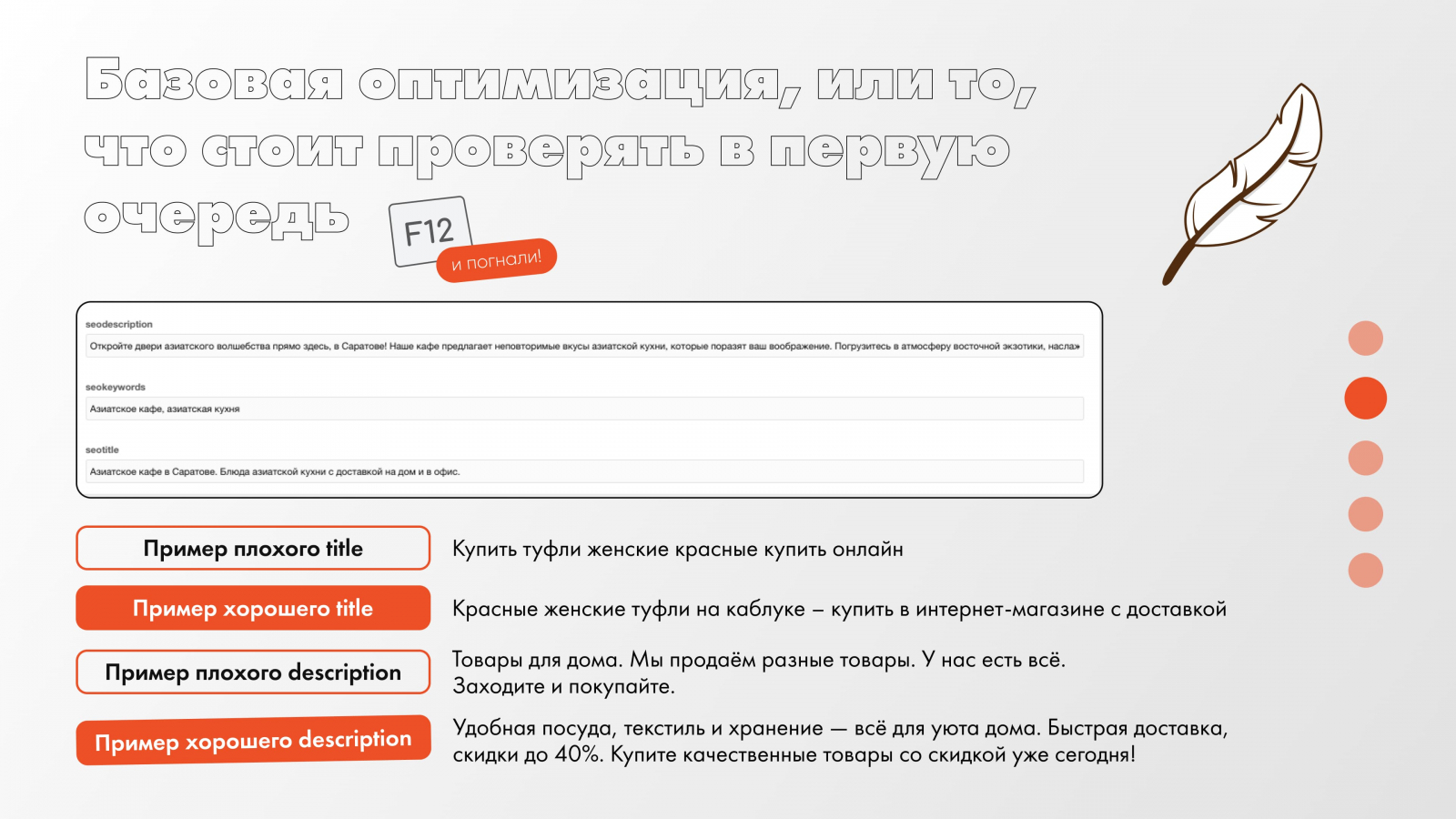

Базовая оптимизация, или то, что стоит проверять в первую очередь (F12 и погнали)

Метаданные, или title и description, написанные понятным человеческим языком, а не просто набором ключевых запросов. Метаданные — это заголовок (<title>) и описание (<meta name="description">) страницы, которые отображаются в результатах поиска.

Важность этого пункта заключается в следующем: помогают поисковым системам понять, о чем страница, и двигать ее по необходимым ключевым запросам выше, влияют на CTR (кликабельность объявлений), то есть чем привлекательнее расписан title и description, тем чаще пользователи будут кликать на это предложение. Соответственно, если в метаданных будут только ключевые слова, никто кликать-то и не будет, посчитают, что спам (люди уже прошаренные, не прокатит).

Решение: либо лезем сами в админку сайта, либо запрашиваем отчет у исполнителя по проведенной работе со скринами.

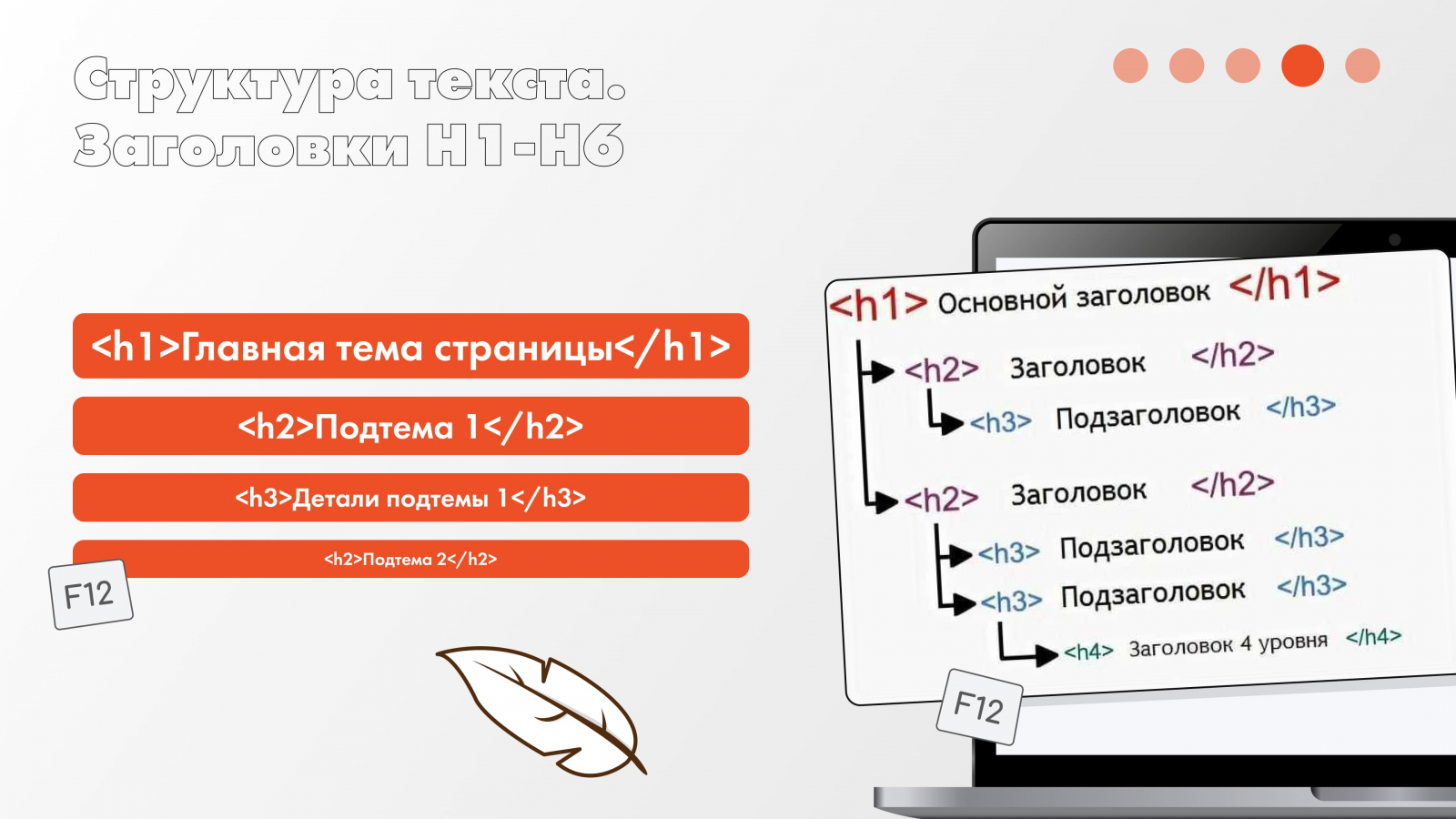

Заголовки H1-H6 — это HTML-теги, которые задают структуру текста: <h1> — основной заголовок, <h2> — подзаголовок, <h3> — подпункт к <h2> и т. д. Тут получается производная от прошлого пункта, поэтому отмечаем следующую важность: помогает поисковым системам понять структуру контента и позволить ее двигать выше в поисковой выдаче, улучшает читаемость пользователей, то есть четкая структура/форматирование априори приятнее читать, чем «Именем Короля…» и так шесть листов сплошного текста.

Решение: либо лезем сами в админку сайта, либо запрашиваем отчет у исполнителя по проведенной работе со скринами.

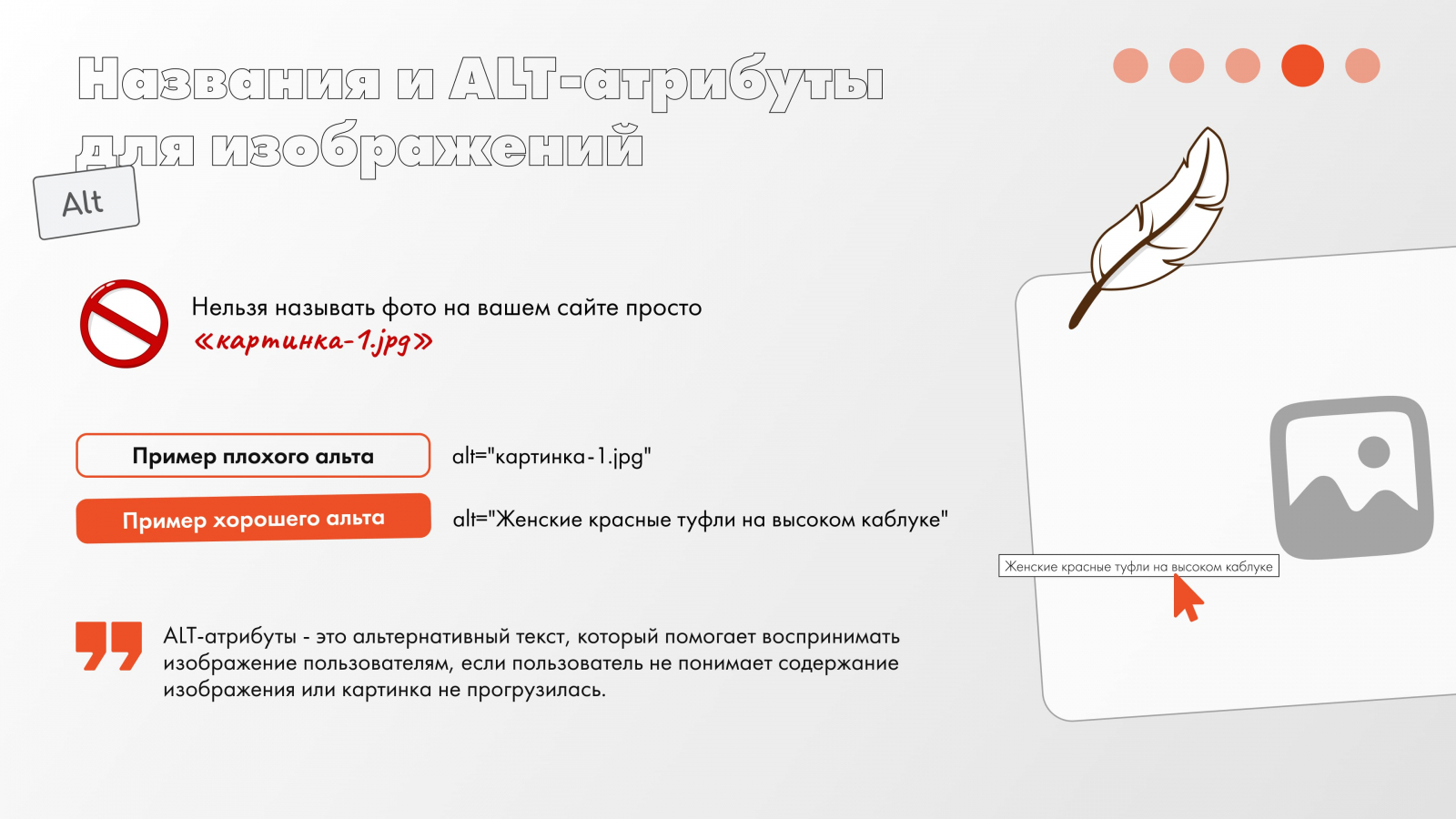

Названия и ALT-атрибуты для изображений, или, по-простому, нельзя называть фото на вашем сайте просто «картинка-1.jpg». Таких названий тысячи и миллионы, а поисковику надо знать, что индексировать и закидывать в такую замечательную вкладку, как «фото» в поисковике. Помимо этого, при хорошем раскладе к вам на сайт могут попасть только по одному фото (это если помечтать).

Что касается ALT-атрибутов, то это альтернативный текст, который помогает воспринимать изображение пользователям, если: пользователь не понимает содержание изображения или картинка не прогрузилась. Ну и не забываем, что по альтам поисковики тоже понимают, что происходит на странице в целом.

Решение: делимся сервисом, который поможет вам проверить ALT-атрибуты. Если покопаться, там еще кучу прикольных инструментов для проверки можно найти!

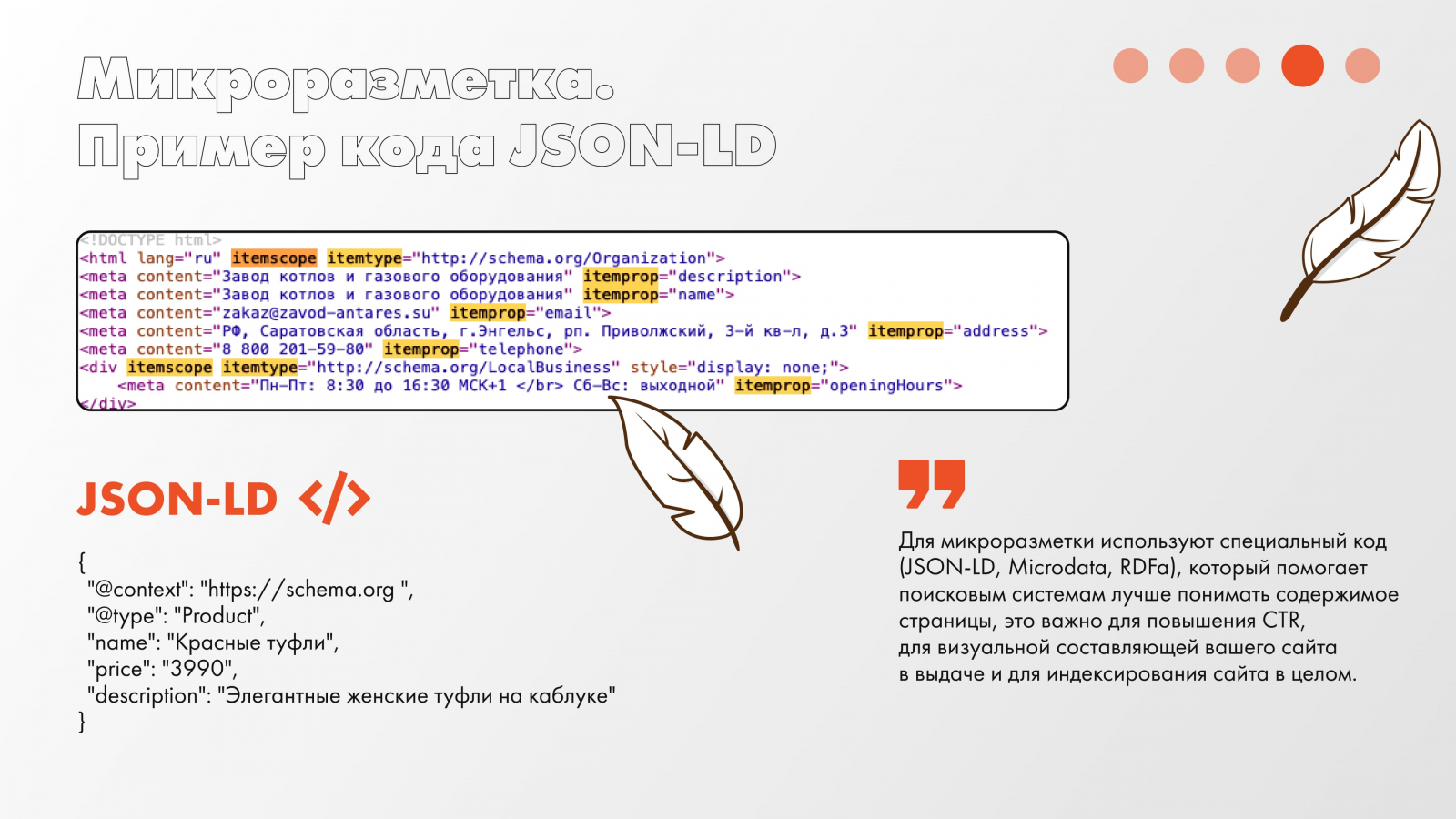

Микроразметка Schema.org помогает вам завладеть вниманием пользователя. Кратко, микроразметка — это набор тегов и атрибутов, помогающих описать для поисковика то, что находится на странице, и для этого как раз используют словарь Schema.org. Поисковики не просто так трудились, создавая эту базу знаний, чтобы ускорить процесс обработки и сегментации информации, ну и чтобы показывать пользователям релевантные сайты. Напомним, что на 2025 год только в России насчитывается около 1 262 614 сайтов, и большая их часть хочет попасть в топ, чтобы забирать свой процент трафика.

Для микроразметки используют специальный код (JSON-LD, Microdata, RDFa), который помогает поисковым системам лучше понимать содержимое страницы. Соответственно, делаем вывод, что данный пункт важен для повышения CTR, для визуальной составляющей вашего сайта в выдаче и для индексирования сайта в целом.

Дополнительно: если у вас на сайте есть FAQ (а быть он, по-хорошему, должен), на нем тоже должна быть разметка!!

Решение: на такую проверку мы тоже найдем того, кто сделает это за нас! Здесь нам поможет Яндекс Валидатор микроразметки. Просто вставили адрес своего сайта и ждете ответ от сервиса.

Технические работы (в основном копаемся в сайте)

Сделаем лирическое отступление. При разработке сайта всегда стоит проводить консультацию с SEO-специалистом. Сейчас вы, может, не захотите продвижение, но потом оно вам просто будет необходимо. Простой пример: вы сделали сайт красивый, стильный, но под SEO не адаптировали, не захотели. Пройдет время, вы поймете важность SEO, придете продвигаться, а вам скажут, что сайт перелопачивать надо. А это иногда может выйти по ценнику как ваш уже разработанный.

Испугались? Вот чтобы такого не было, давайте читать, что у нас там дальше.

Корректная настройка редиректов со страниц 301 и 302. Данные страницы зачастую вылезают, когда у статьи/товара/категории сменился URL навсегда, если вылезает 302, значит данная страница временно отсутствует, к примеру акция, которая позже может вернуться. Главное — проверять наличие данной страницы и ее верный редирект, это помогает избегать дублей контента, сохранять ссылочный вес при смене URL и в целом улучшает юзабилити сайта, то есть пользователю комфортнее пользоваться вашим ресурсом.

Решение: разработать страницу (если таковой нет), проверить ее работоспособность вручную.

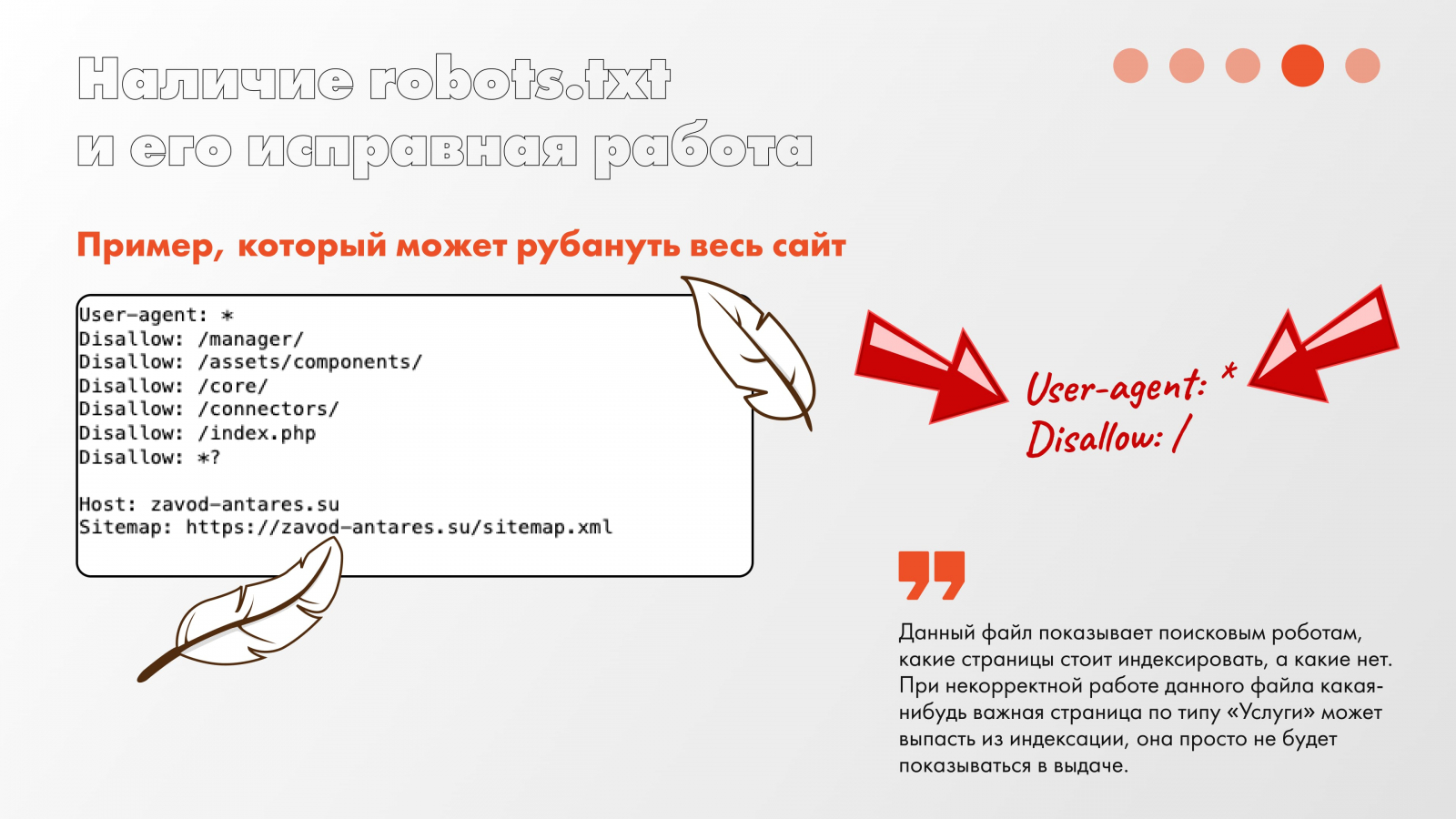

Наличие robots.txt и его исправная работа. Данный файл показывает поисковым роботам, какие страницы стоит индексировать, а какие нет. При некорректной работе данного файла вам просто могут обрубить концы, и какая-нибудь важная страница по типу «Услуги» просто может выпасть из индексации, она просто не будет показываться в выдаче. Но помните, что можно блокнуть и весь сайт.

Решение: и мы снова возвращаемся к нашему любимому Яндексу с его валидатором по анализу robots.txt. Как с ним работать, думаем, вы уже поняли.

Автоматическая генерация актуального Sitemap.xml, или же карта сайта. То есть простой перечень страниц сайта, которые можно проиндексировать. Можно подумать, что карта сайта не отличается от robots.txt, но постараемся быстро и кратко. Robots.txt позволяет закрыть какие-то файлы от индексации (админ-панель), а вот Sitemap.xml направлен на индексирование именно новых и актуальных страниц, то есть у них разные предназначения. Соответственно, чтобы ускорить процесс поиска новых страниц поисковиком, в обязательном порядке нужно иметь карту сайта, что особенно актуально для сайтов, где 198398439 страниц.

Решение: о мой бог, Валидатор, ты снова тут? Спасибо, что ты есть, не нужно искать кучу разных сервисов…

ЧПУ, ха-ха-ха, поняли? Ладно, всё просто, это человекопонятные адреса страниц, то есть то, что пользователь поймет сразу. Это упрощает восприятие страниц и сайта в целом и помогает в использовании ключевых запросов при продвижении.

Решение: тут всё можно глянуть самостоятельно, так как ЧПУ отображаются в поисковой строке. А вот их релевантность уже стоит обсуждать со специалистом.

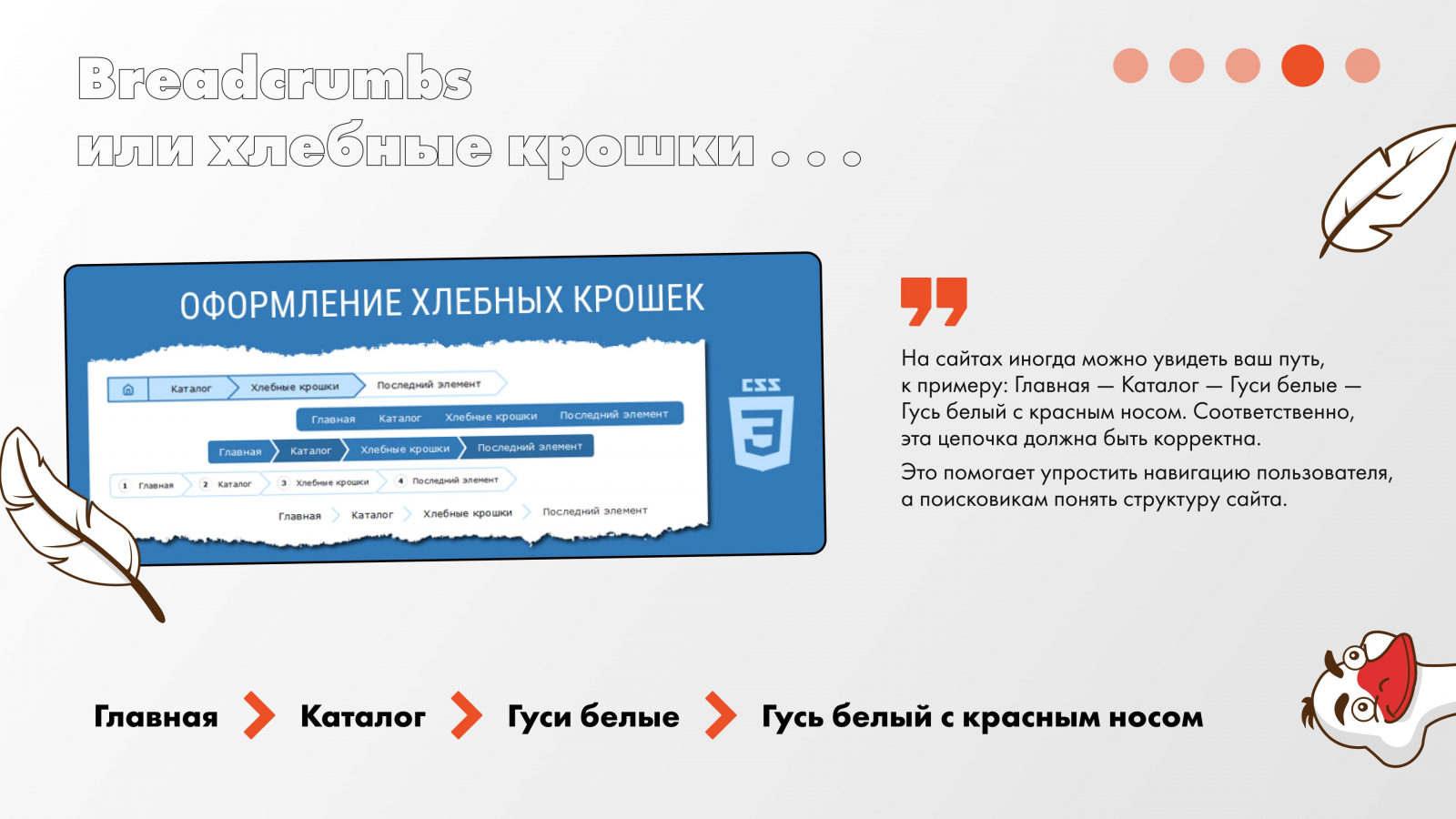

Breadcrumbs, или хлебные крошки, ведут туда, куда нужно. На сайтах иногда можно увидеть ваш путь, к примеру: Главная — Каталог — Гуси белые — Гусь белый с красным носом. Соответственно, эта цепочка должна быть корректна, и чтобы вместо «Гусь белый с красным носом» не вылез «Гусь белый с синими глазами, как голубая лагуна…» Это помогает упростить навигацию пользователя, а поисковикам понять структуру сайта.

Решение: все своими ручками, ну, либо, запросить отчет!

Блог. Особо любимая часть того, кто пишет этот текст. Важно, чтобы у вас была страница со статьями, адаптированными под SEO (то есть с наличием ключевых запросов). Вы таким образом показываете, что вы активисты, укрепляете доверие к сайту, так еще и увеличиваются шансы на ранжирование страниц по информационным запросам.

Решение: текст может написать копирайтер либо своими ручками. В редких случаях SEO-специалист пишет сам, так как не знает всю подноготную вашего бизнеса, однако он может внести необходимые для продвижения корректировки.

Производительность, чтобы быстро и без косяков

Изображения конвертированы в WebP и AVIF. Это форматы, которые не замедляют загрузку фотографий на сайте, что в дальнейшем сказывается на скорости загрузки всей страницы. Это особенно важно, если у вас интернет-магазин и куча фотографий. Дополнительно напишем, что даже если у вас JPEG и он весит килобайты, готовьтесь в целом к плохому качеству фото.

Решение: попробуйте скачать несколько фото с сайта и посмотреть их формат и сколько они весят.

Lazy Load, или сайты тоже умеют лениться. На скорость загрузки сайта также влияет прогрузка всех изображений разом, соответственно, проводят настройку Lazy Load, когда изображения прогружаются только при скролле вниз. Улучшаем производительность, экономим трафик и ускоряем начальную загрузку.

Решение: во-первых, можно попробовать посмотреть самостоятельно (особо чего не поймете), во-вторых, запросить информацию у разработчиков, в-третьих, проверить самостоятельно через сервис, но лучше, конечно, всё уточнять.

Адаптивная верстка с упором на mobile-first. Автор статьи уже настолько преисполнился этим пунктом, что осталось только начать верстать. Еще на этапе разработки сайта, по современным тенденциям, всегда стоит делать упор на мобильную версию сайта, так как чаще всего именно со смартфона смотрят ваш сайт. Помимо этого, важно соблюдать адаптивность каждой страницы по разрешениям, а еще лучше вкусить всю прелесть отзывчивой верстки, когда плевать какой размер устройства, ваш сайт все равно будет выглядеть круто. Тем более пользователю будет глубоко плевать на товар, если он уехал в текстуры…

Решение: просто откройте мобильную версию сайта через телефон и покликайте. Удобно ли вам? Удобно ли вашим клиентам? Все ровненько?

Редирект без www на www. Тут, чтобы максимально просто, один и тот же сайт поисковыми системами будет восприниматься как два разных, один с www, второй без www, что приведет к проблемам в индексации. Это также упрощает работу самих специалистов и гарантирует безопасность сайта, что его никто не взломает.

Решение: для проверки есть простой сервис, который поможет вам увидеть не только ошибку редиректа, но и другие важные недочеты.

Выставленный канонический URL, если по-человечески, указано, какая страница сайта является основной (если есть дубли), то есть таким образом SEO концентрируется на определенной странице и упрощает ее индексацию.

Решение: тут стоит делать проверку, если вы думаете или знаете, что у вас есть дубли страницы. На всякий просто можно запросить отчет у исполнителя, чтобы скрин показал.

Пример кода: <link rel="canonical" href="https://example.com/zhenshchinam/tufli/krasnye-tufli " />

Дополнительные советы

Доверяй, но проверяй, и для этого у нас есть куча сервисов и наша излюбленная Яндекс Метрика. Это как отдельный мир, который вам предстоит изучать и изучать. Вы можете анализировать источники входа, изучать тепловую карту, чтобы понять, куда чаще всего кликали, просматривать путь каждого посетителя, если настроен вебвизор, и так далее по списку.

Также стоит обратить внимание на следующие показатели. Core Web Vitals:

- Largest Contentful Paint (LCP) — 2.1 секунды (норма ≤ 2.5с)

- First Input Delay (FID) — 87 миллисекунд (норма ≤ 100мс)

- Cumulative Layout Shift (CLS) — 0.08 (норма ≤ 0.1)

Всё должно быть в зеленой зоне. Также прогоняйте сайт через все доступные валидаторы:

- Google PageSpeed Insights: 89 баллов (мобильная), 92 балла (десктопная) — больше 85, как и требовалось

- Core Web Vitals в Google Search Console: статус «Хорошо» по всем показателям

- Lighthouse и DevTools Audit: критических ошибок нет, только мелкие рекомендации.

И вот теперь можно считать, что ваш сайт готов к запуску по SEO (а вообще всё это должно быть изначально при сдаче сайта клиенту). Помните: каждое изменение в коде может повлиять на производительность. Проверяйте метрики после обновлений. Также не забывайте, что всё, что мы сегодня рассказали вам, это только часть того, что делает SEO-специалист и команда разработки, ведь там еще так много всего…

По классике, собираем это для вас все в единый чек-лист! Пользуйтесь!

Статья написана при поддержке Директора по развитию бизнеса Пантелеева Алексея. Спасибо тебе, поклон!