Как провести полный SEO-аудит сайта: поэтапное руководство и 25+ полезных инструментов.

Первостепенные задачи, стоящие перед специалистом по SEO – это всестороннее изучение контента, структуры, технических особенностей сайта и влияющих на него внешних факторов, выявление слабых мест, планирование и реализация необходимых доработок, с учетом всех принципов работы поисковых систем. А самое главное, что проводить такой анализ и оптимизацию нужно регулярно, ведь поисковые алгоритмы постоянно совершенствуются, и многие тактики SEO устаревают и перестают работать.

Несмотря на то, что максимально высоких результатов SEO-аудита вы сможете добиться, только прибегнув к сотрудничеству с профессионалами, вы и сами можете многому научиться, используя нижеописанное руководство, ссылки на внешние материалы и инструменты SEO, которые вы найдете во второй половине статьи. Для вашего удобства, все инструменты в статье кликабельные. На протяжении всей статьи будут упоминаться инструменты Яндекса и Google, как самые главные и удобные инструменты для поискового продвижения.

Этап 1. Подготовка к SEO-аудиту

Лучше всего начать со сканирования сайта, используя краулер (поисковый робот), например, Screaming Frog SEO Spider. Этот инструмент анализирует код, контент, внутренние и исходящие ссылки, изображения и другие элементы сайта с точки зрения SEO и составляет общее представление о положении дел.

нельзя забывать о возможностях стандартных сервисов поисковых систем — Яндекс.Вебмастер и Google Webmaster Tools – они также предоставляют большое количество ценной информации.

Этап 2. Внутренний SEO-аудит

Технический аудит

Robots.txt

Файл robots.txt по желанию размещается в корневой директории сайта и содержит инструкции по его индексированию для роботов поисковых систем.

С использованием различных директив robots.txt можно:

- запретить или разрешить роботам индексировать некоторые разделы и страницы сайта или весь сайт целиком;

- указать путь к карте сайта sitemaps.xml, способствующей правильному индексированию;

- дать понять роботу, какое зеркало сайта — при наличии нескольких его копий — является главным, и какие зеркала индексировать не нужно;

- снизить нагрузку на сайт от поисковых роботов, если в определенной ситуации необходимо экономить ресурсы.

При этом разные правила можно создавать для отдельных поисковых систем и даже для разных роботов одной и той же системы.

Используйте все возможности robots.txt. Убедитесь, что запрещено индексирование «секретных» областей сайта, страниц с контентом низкого качества и страниц-дубликатов. Проверьте, разрешен ли доступ ко всем областям сайта, которые должны быть проиндексированы поисковыми системами.

При анализе файла robots.txt вам помогут Яндекс.Вебмастер, Google Webmaster Tools и другие сервисы.

Указания для поисковых роботов в тэгах <meta>

Но для еще более гибкого управления индексированием сайта и его отдельных страниц поместите директивы для поисковых роботов в тэгах <meta>. Так вы разрешите или запретите роботам индексирование конкретных страниц и переход по размещенным на них ссылкам.

XML Sitemap

Файл Sitemap (карта сайта) добавляется в корневую директорию сайта и дает поисковым системам информацию о том, какие страницы сайта должны быть проиндексированы, какие из них в первую очередь, как часто они обновляются.

Если на сайте уже есть файл Sitemap (желательно в формате XML), то проверьте корректность его кода с помощью валидатора (такой инструмент есть, в частности, в сервисах для веб-мастеров от Яндекса и Google). Позаботьтесь также о том, чтобы файл Sitemap содержал не более 50 тыс. URL и весил не более 10 Мб. Если эти лимиты превышены, то придется создать несколько файлов Sitemap и один индексный файл Sitemap Index со списком всех карт.

Если карты сайта пока нет, создайте ее вручную или с помощью одного из множества инструментов (например, XML Sitemap и его аналогов, плагинов для WordPress и других распространенных движков; с бОльшим списком инструментов можно ознакомиться на ресурсах Google).

После создания проанализируйте карту в валидаторе и сообщите поисковым системам о ее существовании через их сервисы для веб-мастеров, а также посредством добавления пути к Sitemap в файл robots.txt.

Markup Validator – валидатор html-кода для устранения неточностей и ошибок кода, снижающих позиции сайта в выдаче. Создан сообществом, которое занимается разработкой и утверждением международных стандартов веб-разработки.

Оценка качества индексирования сайта

Команда site: обычно вводится в строке поисковых машин, чтобы ограничить зону поиска определенным доменом. Но эта команда позволяет также узнать приблизительное количество всех страниц сайта, которые были проиндексированы. Для этого просто введите site: c доменным именем без слов поискового запроса.

Сравните количество проиндексированных страниц с общим количеством страниц сайта, которое вы узнали на стадии создания sitemap.xml и сканирования сайта с помощью Screaming Frog, Xenu’s Link Sleuth или других инструментов.

Если оба числа почти одинаковы, значит, сайт проиндексирован хорошо. Если проиндексированы не все страницы, то выясните причину — возможно, ваш сайт не оптимизирован для поисковых систем, имеет много закрытых от индексирования разделов и страниц или попал под санкции. Если же количество проиндексированных страниц превосходит реальное их количество, то, вероятно, на вашем сайте есть много дублированного контента, о котором речь пойдет далее в этой статье.

Рассмотрим подробнее, как работает и что показывает Google Webmaster Tool.

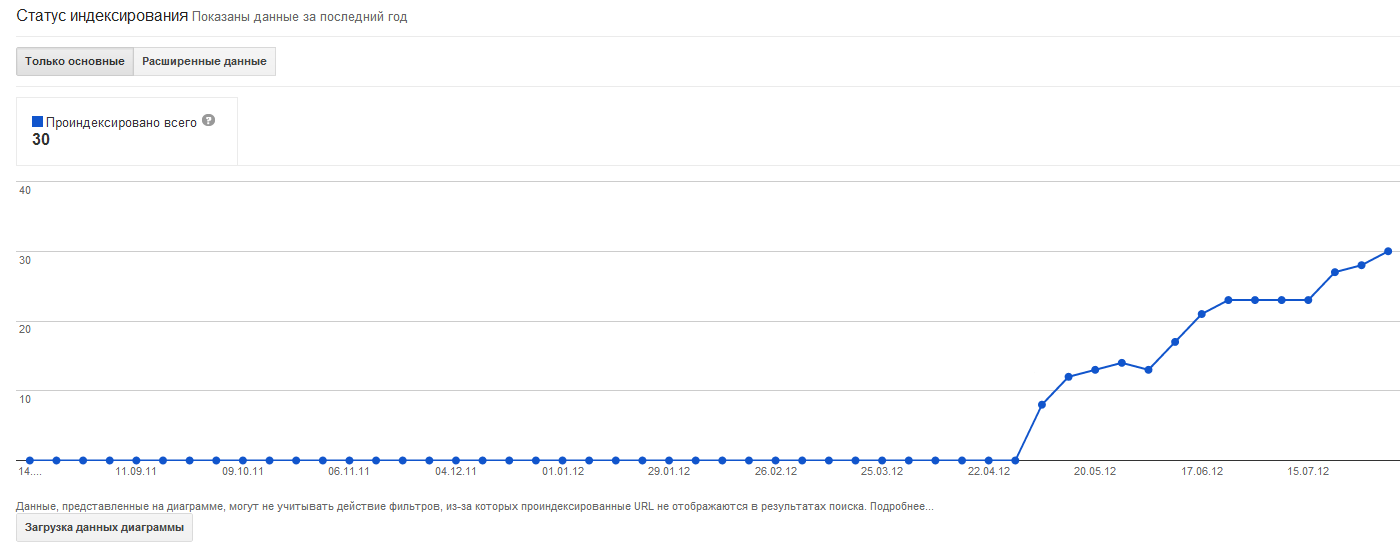

При его открытии отображается подобный график:

Он показывает, сколько страниц проиндексировано в настоящий момент. На графике отображены данные за последний год.

И если на нем видно, что количество проиндексированных страниц постоянно увеличивается, то это замечательно. Это означает, что новый контент на сайте находится, ранжируется и добавляется в индекс Google.

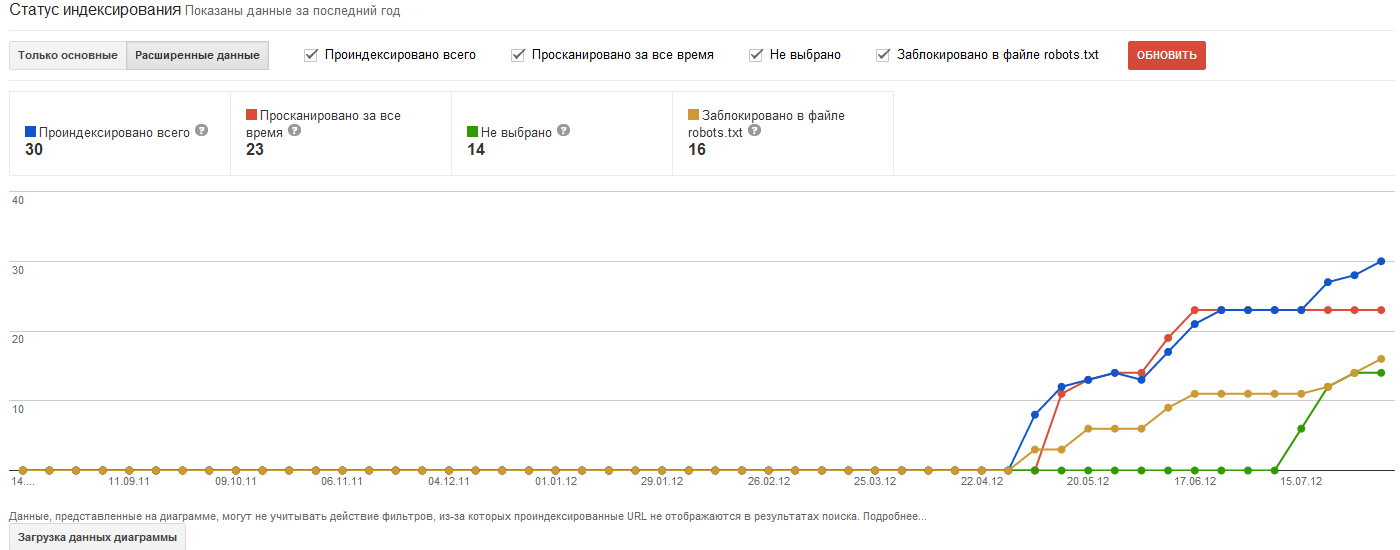

Но иногда необходимо получить более подробную информацию. Для этого есть кнопочка «Расширенные данные». После нажатия на нее, открывается новый график:

На нем отображается не только количество проиндексированных страниц на данный момент времени, но и общее количество – те которые были просканированы за весь показанный период. Также показывается число страниц, заблокированных в файле robots.txt и страницы, которые не попали в индекс.

Коды состояния HTTP

Код состояния HTTP – это часть первой строки ответа сервера при запросах по протоколу HTTP. Он представляет собой целое число из трех арабских цифр, находящееся в первой строке ответа сервера при запросе к веб-странице, и показывает ее текущее состояние. Необходимо установить, при обращении к каким URL сайта появляется сообщение об ошибке — обычно с кодом вида 4xx или 5xx. Например, широко известно: код 404 означает, что страница не найдена, а код 503 — что обнаружена внутренняя ошибка сервера. Код 200 говорит о том, что все работает хорошо.

Если на сайте используются перенаправления (редиректы) с одних URL на другие, то убедитесь, что это именно 301 редиректы, а не 302 и не перенаправления, прописанные в тегах <meta> или с помощью JavaScript. Используя 302 redirect (Temporary redirect) - «временно перемещен» – вместо 301, исходный URL будет оставаться в индексе Google, и удерживать свои позиции, как если бы страница все еще была доступна. Однако пользователи, которые будут кликать на ссылке, попадут на ваш новый URL – именно туда, куда вы намерены их направить.

Для проверки кодов состояния HTTP можно пользоваться различными сервисами — например, специальным инструментом от Monitor Backlinks или встроенными средствами Яндекс.Вебмастер и Google Webmaster Tools.

URL страниц сайта

Грамотный URL страницы имеет длину не более 100-120 символов, состоит в основном из легкочитаемых слов (например, вот такой: http://myacademy.ru/courses/bazovyi_kurs_po_seo/) содержит ключевые слова, описывающие страницу.

Все это способствует не только лучшему поисковому индексированию, но и повышению удобства для посетителей сайта.

Старайтесь избегать сложных адресов с параметрами и отдавать предпочтение статичным ссылкам, использовать для разделов в структуре сайта директории, а не субдомены, разделять отдельные слова в URL дефисами или знаками подчеркивания, такое написание лучше воспринимается посетителями сайта.

Скорость загрузки сайта

Пользователи интернета нетерпеливы и сразу покидают медленные сайты. Так же и у поисковых систем есть определенный лимит времени на обработку каждого сайта, поэтому быстрые сайты индексируются тщательнее и за более короткий период времени.

Как проанализировать скорость загрузки сайта?

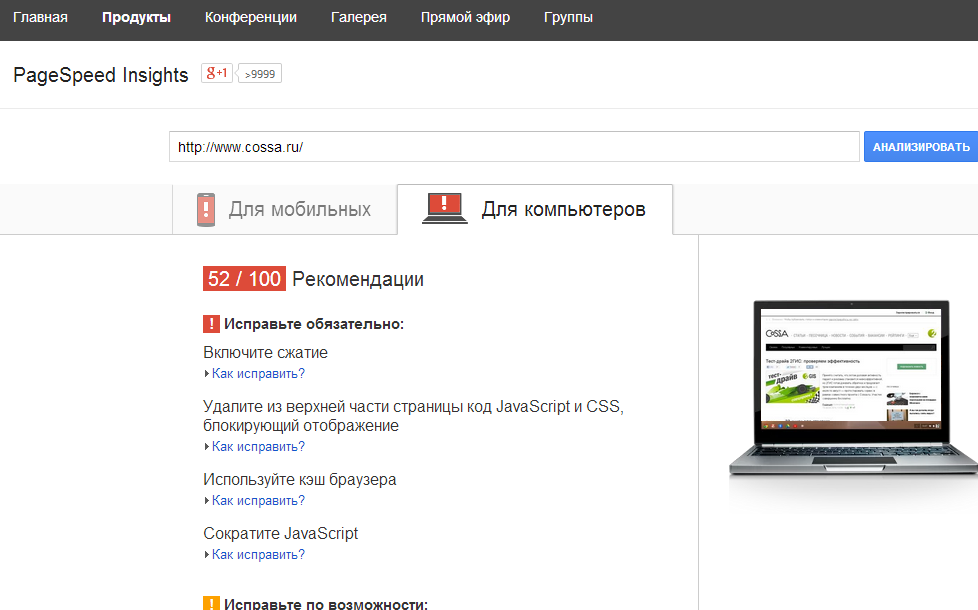

Применяйте встроенные средства систем веб-аналитики (например, отчеты о времени загрузки страниц есть в Google Analytics и Яндекс.Метрике. А для наиболее полного анализа скорости можно использовать специализированные сервисы, например, Google PageSpeed Insights:

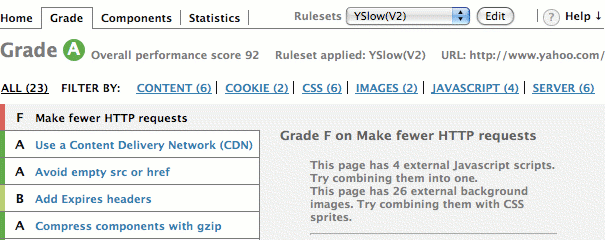

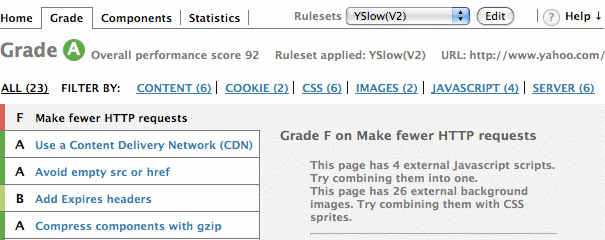

или YSlow :

Если сайт нуждается в ускорении, оптимизируйте изображения в графическом редакторе с помощью функции подготовки графики для публикации в интернете, сократите объем кода HTML и CSS, уберите лишний код JavaScript, разумно используйте сжатие, кэш браузера и сервера и осуществите другие необходимые действия.

Этап 3. Аудит структуры сайта

Архитектура сайта

Сайт должен иметь ясную и логичную структуру страниц, упорядоченных по категориям и тесно связанных между собой внутренними ссылками.

Избегайте большого количества уровней вложенности: пусть все важные страницы будут расположены в одном клике от главной, а другие страницы — не далее, чем в 3-4 кликах.

Такая простая для посетителя архитектура сайта позволит поисковым машинам быстрее проиндексировать все страницы сайта, а посетителям поможет не заблудиться и быстро найти нужную информацию, что, в конечном счете, тоже положительно повлияет на SEO.

Старайтесь не использовать на сайте навигационные меню, созданные с помощью Flash и JavaScript. Это нежелательно, даже несмотря на то, что поисковые системы сегодня намного умнее, чем в прошлом.

Если все же JavaScript-навигация присутствует на сайте, проведите два этапа индексирования сайта с помощью Screaming Frog, Xenu’s Link Sleuth или другого специализированного сервиса (мы писали об этом в начале этого руководства): с включенным и отключенным JavaScript. Это позволит выявить, оказались ли какие-то разделы и страницы сайта недоступными для индексирования из-за наличия JavaScript-меню.

Внутренние ссылки

Внутренняя перелинковка способствует лучшему индексированию сайта и разумному распределению веса страниц.

В этом нелегком деле поможет Page Rank Decoder – инструмент для прогнозирования распределения веса страниц при использовании различных схем перелинковки.

Установите между страницами сайта множество связей, соблюдая при этом простые требования:

- в качестве анкоров используйте не только ключевые слова, но и различный нейтральный текст — например, такие призывы к действию, как «ознакомьтесь», «скачайте» и т.п. (это делает общую массу ссылок более естественной для поисковых систем, тогда как изобилие ключевых слов выглядит подозрительно);

- страницы и ключевые слова в составе анкоров должны быть релевантны контенту целевых страниц;

- направляйте больше ссылок на те страницы, которые должны занять более высокие позиции;

- ссылайтесь на такие страницы с «Главной»;

- не размещайте на одной слишком большое количество внутренних ссылок.

Этап 4. Аудит контента

Заголовки страниц <title>

Заголовки страниц — это первое, что видит ваша аудитория в поисковой выдаче и в социальных сетях, после чего они принимают решение посетить ваш сайт. Поэтому важно уделить оптимизации заголовков особое внимание.

Формулируйте заголовки кратко: старайтесь не выходить за рамки 70-90 символов, иначе заголовок может быть обрезан в результатах поиска, в социальных сетях, а пользователи Twitter не смогут добавить к нему свои комментарии.

Заголовки служебных и различных информационных страниц сайта (за исключением статей и других подобных контентных продуктов) должны точно описывать их содержание.

Не забудьте добавлять в заголовки страниц ключевые слова — желательно ближе к началу. Но не переходите границы разумного: как и в случае со всем контентом страницы, придумывайте заголовки для людей, а не для машин.

Убедитесь, что все страницы на сайте имеют уникальные заголовки. В этом вам поможет, например, сервис Google Webmaster Tools, в котором есть инструмент поиска страниц с одинаковыми заголовками.

Описания страниц в тэгах <meta>

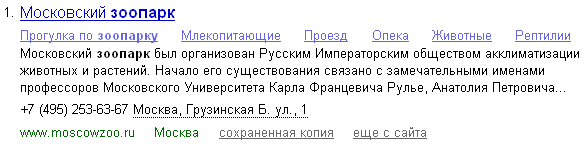

Описание страницы из тэга <meta> может включаться в сниппет в поисковой выдаче, поэтому стоит ответственно подойти к управлению мета-описаниями важных страниц

Сниппет — это блок информации о найденном документе, который отображается в результатах поиска. Сниппет состоит из заголовка и описания или аннотации документа, а также может включать дополнительную информацию о сайте.

Составляйте описания из нескольких слов, общей длиной до 150-160 символов. Это должен быть связный текст, рассказывающий о конкретной странице, а не обо всем сайте, и не перегруженный ключевыми словами. Поддерживайте описания в актуальном виде: если информация на странице обновилась, и описание устарело, внесите в него необходимые изменения.

Пусть каждая страница имеет уникальное описание. Выявить все страницы с одинаковой информацией в тегах <meta> можно с помощью Google Webmaster Tools.

Ключевые слова в тэгах <meta>

Уже достаточно давно большинство поисковых систем игнорируют ключевые слова в тэгах <meta>, так что есть смысл вообще не добавлять эту информацию в код сайта, чтобы не предоставлять конкурентам лишние данные о вашей SEO-стратегии.

Контент

Эта истина уже банальна, но: вы должны создавать контент для людей, а не для поисковых машин. Не стоит слишком увлекаться поисковой оптимизацией — это сделает текст почти непригодным для комфортного чтения и, в конечном счете, отрицательно скажется на результатах SEO.

Убедитесь, что страницы вашего сайта содержат ценный для аудитории, уникальный контент, а не сверхоптимизированный текст и копии с других сайтов, и что объем контента на каждой странице превышает 300-400 слов (есть данные, что при прочих равных условиях страницы с 2000 слов и более располагаются обычно выше в результатах поиска). В современных алгоритмах оптимальный объем контента автоматически формируется для разных тематик. В некоторых тематиках будет достаточно и 200-400 слов на странице, а кое-где понадобятся большие тексты. Если к вопросу подходить очень серьезно, то объем контента для каждой страницы определяется анализом выдачи по конкретным запросам в конкретном регионе.

Здесь вам на помощь придут такие сервисы:

ContentMonster

Биржа контента. Проверяет уникальность текста, следит за качеством работы авторов, возвращает 120% стоимости текста, если вы сочтете его некачественным.

Webartex

Объединяет биржу статей и сервис статейного продвижения. Копирайтеры напишут статьи под ваш проект, вебмастера разместят статьи с вечными ссылками на надежных площадках.

Content-Watch

Инструмент для проверки уникальности текстового контента. Позволяет проверить уникальность текста, введенного пользователем, и уникальность контента вашего сайта.

Advego Plagiatus

Бесплатный софт для проверки уникальности текстов. Показывает процент совпадения, источники текста. Проверяет тексты и веб-страницы.

Обратите внимание на наличие ключевых слов в тексте страниц — прежде всего, в первых нескольких абзацах. Отредактируйте текст так, чтобы использование ключевых слов не приводило к повторениям и бессмысленным фразам, написанным с одной лишь целью в очередной раз упомянуть ключевое слово. Красивый, стройный, полезный текст, с незаметными для читателя ключевыми словами — вот к чему вы должны стремиться.

Само собой разумеется, что нужно позаботиться, чтобы текст на сайте был лишен грамматических ошибок: безграмотность говорит о непрофессионализме автора, поэтому такой контент будет занимать низкие позиции в результатах поиска.

В этом вам помогут такие сервисы, как:

Орфорграф – один из самых первых сервисов проверки орфографии, который предложил рунету Артемий Лебедев.

Проверка орфографии от Яндекс.Вебмастер – обрабатывает веб-страницу целиком. Проверять правописание на Яндексе важно с точки зрения написания неологизмов. Как писать: «Твиттер» или «Твитер»? Яндекс расскажет, в каком виде его робот скорее распознает спорные слова.

Дублированный контент

Если на вашем сайте или за его пределами присутствует контент, дублирующий другие материалы сайта, поисковые системы должны определять, какую именно версию проиндексировать и показать в результатах поиска. И эта проблема только усугубляется по мере того, как другие сайты ссылаются на разные копии страницы или одну и ту же страницу, открывающуюся по разным URL.

Вот некоторые причины возникновения дублированного контента:

- CMS сайта может делать одни и те же страницы доступными по разным ссылкам;

- вторая часть URL на многих сайтах формируется динамически, содержит дополнительные параметры, меняющиеся в зависимости от различных факторов;

- контент сайта часто воруют, размещают на других ресурсах без обратной ссылки, и поисковая система неспособна связать его с первоисточником;

- при посещении сайта может создаваться сессия с уникальным идентификатором, который используется в динамических URL (это нужно, например, для временного хранения информации о добавляемых в корзину товарах — вплоть до оформления заказа);

- версии страниц сайта, оптимизированные для печати, могут расцениваться как дубликаты.

Дублированный контент внутри сайта можно выявлять, например, с помощью Google Webmaster Tools (сервис умеет находить страницы с одинаковыми заголовками и мета-описаниями) и поисковых операторов, которые могут указываться вместе с запросами в строке поисковых машин.

Решить проблему дублированного контента можно путем простого удаления дубликатов, создания 301 редиректов, запрета на индексирование дубликатов в файле robots.txt или в мета-тэгах отдельных страниц, использования директивы rel="canonical" и другими способами.

Внутритекстовые заголовки

Четко структурируйте текстовые публикации. Используйте заголовки (тэг <h1> — для самых значимых из них), подзаголовки нескольких уровней, выделяйте отдельные фрагменты текста жирным шрифтом, курсивом.

Конечно, не стоит переделывать все заголовки на вашем сайте с <h2>,<h3>..<h6> в <h1> - ни к чему хорошему в плане оптимизации это не приведёт. В идеале на странице должен присутствовать всего один заголовок первого уровня, который содержит в себе два-три заголовка второго уровня, в которых, в свою очередь, "вложены" заголовки рангом поменьше и так далее. Структура документа должна иметь примерно такой вид:

При этом важно соблюдать меру: слишком много заголовков и ключевых слов, выделенных жирным шрифтом, оттолкнут читателей не меньше, чем монотонный неструктурированный текст. Продуманное форматирование текста значительно облегчает читателю восприятие текста, а заголовки с важными словами еще и положительно сказываются на SEO. А наилучший способ структурирования текстов на сайте — думать, прежде всего, о людях и сделать несколько легких «реверансов» в сторону поисковых машин.

Изображения

Часто посетители ищут информацию по картинкам, и таких пользователей очень много. Google и Яндекс предоставляют всем желающим поиск по картинкам, где с помощью ключевых слов каждый может найти нужные изображения.

А если есть поиск, значит, есть и трафик, который можно использовать в своих целях. Правильная оптимизация изображений под поисковые системы позволит привести на сайт трафик и усилить позиции документов по продвигаемым запросам.

Самые главные атрибуты картинок это ALT и Title. Загружая картинку к посту, нужно лишь прописать эти атрибуты и ваши картинки приведут Вам посетителей.

Для этого проанализируйте все важные изображения на вашем сайте, тематически связанные с окружающим их текстовым контентом. Для полноценного индексирования имен графических файлов, а также значение атрибута alt тега <img> должны содержать слова, описывающие изображение, и желательно ключевые слова страницы. При этом сделайте разными имя файла и значение атрибута alt.

Слова в имени файла стоит разделять дефисами, а не знаками подчеркивания. Для описания следует использовать именно атрибут alt, а не title, и оно должно быть кратким — не длиннее 150 символов, со всеми важными словами в начале текста.

Конечно, очень хорошо бы было, если бы картинки были уникальными, а не просто изображениями, которые первыми попались под руку, или же найденными в интернете.

Позаботьтесь о быстрой загрузке всех изображений, размещаемых на сайте: удаляйте все лишние области, устанавливайте размер картинок не выше минимально необходимого, оптимизируйте их в графическом редакторе с использованием встроенных инструментов подготовки картинок для интернета.

Этап 5. Аналитика

Улучшайте метрики, чтобы легко находиться в поиске при помощи рекомендуемых инструментов:

Seolib.ru — автоматически мониторит изменения позиций сайта в выдаче всех поисковых систем. Контролирует видимость сайта, анализирует качество ссылок, находит и исправляет ошибки оптимизации, работает с ядром ключевых запросов.

Seopult.ru — сервис автоматизированного продвижения сайта. Предоставляет рекомендации по продвижению и удобную систему преднастроек. Закупает ссылки, анализирует эффективность работы.

MegaIndex — еще один сервис для автоматизации продвижения сайта. Экспресс-аудит, счетчик посещаемости, составление семантического ядра и работа с ключевыми запросами, анализ конкурентов, социальных и поведенческих факторов.

BotScanner — анализирует данные о посетителях сайта и делает выводы об их качестве. Позволяет отделить ботов и случайных посетителей от «полезных» пользователей. Оценивает эффективность разных каналов трафика. Наглядно представляет информацию.

Этап 6. Внешний SEO-аудит

Исходящие ссылки

Часто владельцы сайтов внимательно относятся только к получению трастовых обратных ссылок, но заботиться нужно и об исходящих ссылках с вашего сайта на другие ресурсы.

Избегайте ссылок на некачественные сайты и сайты с плохой репутацией: это будет негативно влиять на ваши позиции в результатах поиска. Если размещение такой ссылки все же неизбежно, используйте в теге <href> атрибут rel со значением nofollow для запрета перехода по ссылке для поисковых машин.

Ссылайтесь на внешний контент, тематически связанный с вашей страницей, а в текст ссылок старайтесь включать слова, описывающие целевую страницу.

Регулярно проводите проверку на наличие битых ссылок, то есть тех, переход по которым приводит к ошибкам с кодом вида 4xx или 5xx. Для этого можно использовать Link Checker от W3C и другие сервисы.

Обратные ссылки

Ссылочное ранжирование все еще работает, и нам стоит принимать во внимание количество и качество входящих ссылок, хотя тенденции и говорят о снижении в будущем их значения для продвижения сайта.

Воспользуйтесь такими сервисами, как Majestic SEO, Open Site Explorer, Ahrefs или инструментами для веб-мастеров от Яндекса и Google, чтобы узнать, какое количество сайтов ссылаются на ваш сайт, связаны ли они тематически с вашим сайтом и являются ли они трастовыми.

Если на вас ссылается множество качественных сайтов из той же отрасли, вы приобретаете высокий авторитет. Если же эти сайты имеют плохую репутацию и содержат контент низкого качества, поисковые системы начинают считать таковым и ваш сайт.

Старайтесь приобретать обратные ссылки, в тексте которых присутствуют нужные вам ключевые слова. В этом деле надо соблюдать меру: большое количество входящих ссылок с других сайтов с одинаковым или похожим анкорным текстом может приводить к понижению позиций вашего сайта в поиске по содержащимся в тексте ссылок ключевым словам. Общая масса обратных ссылок на ваш сайт должна выглядеть естественной для поисковых машин: пусть одни ссылки имеют в анкорах ключевые слова, другие — призывы к действию, вроде «щелкните здесь», «ознакомьтесь», или другой нейтральный текст.

RotaPost – покупка ссылок и обзоров, реклама в блогах. Площадка связывает рекламодателей с владельцами блогов, микроблогов и новостных сайтов, готовых предоставить свои ресурсы для размещения ссылок.

B2Blogger – сервис по рассылке пресс-релизов в Рунете. Помогает распространять пресс-релизы по тематическим ресурсам, транслирует публикации в новостные агрегаторы Яндекс и Google. Хорошо индексируется поисковыми системами и сервисами мониторинга.

Pr.Sape – биржа покупки вечных ссылок. Сервис предлагает разные степени настройки, от ручной до полной автоматизации. Позволяет настраивать бюджеты, фильтровать площадки, контролировать индексацию ссылок, покупать ссылки в социальных сетях.

Миралинкс – инструмент статейного маркетинга. Вручную размещает статьи на вручную же проверенных площадках. Есть банк готовых статей, написанных копирайтерами компании.

GoGetLinks – еще одна биржа покупки вечных ссылок. Предлагает размещать ссылки в заметках, контекстные ссылки и ссылки в картинках. Автоматизирует процессы, создает заметки.

SEO-анализ сайтов-конкурентов

Важной частью аудита является изучение стратегий и ошибок ваших конкурентов в области SEO.

Защита от негативного SEO

Негативная поисковая оптимизация объединяет совокупность черных и неэтичных методов и технологий, которыми пользуются конкуренты, чтобы снизить позиции вашего сайта в поисковой выдаче или вообще забанить его в поисковых системах. Вот некоторые способы достичь этих целей:

- хакерская атака и взлом сайта;

- распространение тысяч спамерских ссылок на вашем сайте через комментарии;

- создание клонов вашего сайта и копирование контента без вашего разрешения;

- создание поддельных профилей в соцсетях, через которые распространяется негатив против вашей компании и сайта;

- удаление трастовых ссылок с других сайтов на ваш сайт.

Заключение

Грамотно проведенный SEO-аудит не только сделает ваш сайт более дружелюбным по отношению к поисковым системам, но и одновременно повысит его юзабилити и ценность для посетителей.

При условии правильного и регулярного исполнения (не реже двух раз в год) аудит значительно увеличивает трафик — как поисковый, так и другие его виды, ведь пользователи любят удобные сайты и возвращаются на них снова и снова.