Как промптить, а не гуглить. Полная инструкция и отличия, которые надо знать каждому

AI-ассистенты вроде ChatGPT радикально меняют поведение пользователей в поиске. Ключевые слова в поиске у пользователей постепенно сменяются диалогом с ИИ — человек описывает контекст, получает готовый ответ прямо в чате и все реже переходит на сайты.

В этой статье разбираемся, как ИИ-поиск меняет запросы и структуру трафика, что такое GEO и как настроить продукт и контент так, чтобы вас по-прежнему находили, но уже через ответы нейросетей.

Почему мы начали объяснять, а не гуглить

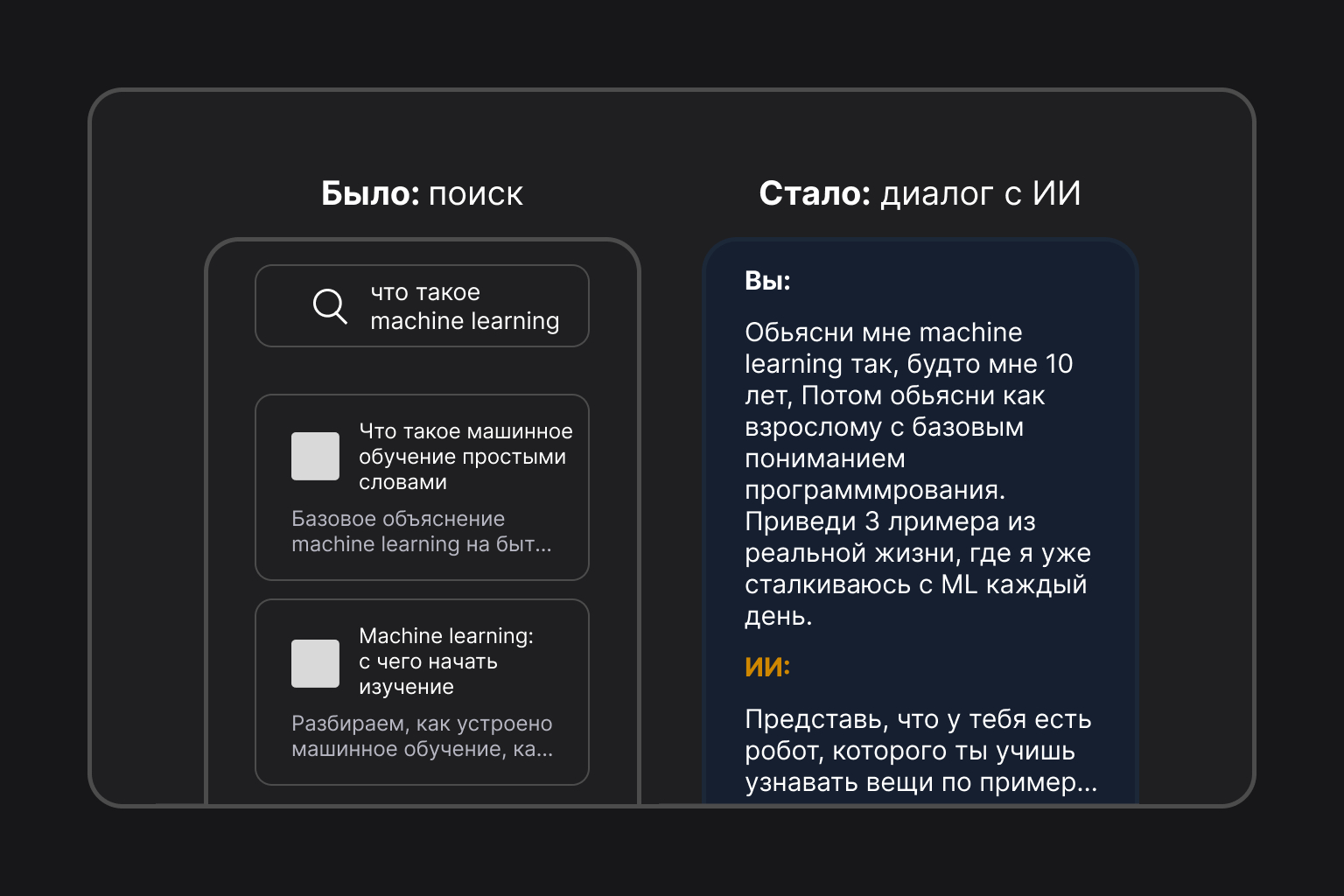

Классический поиск заточен к стилю того, как люди пишут телеграммы. Запрос — это 2–3 ключевых слова, иногда чуть больше:

Google: «лучший смартфон 2025», «купить ноутбук недорого москва».

Средняя длина запроса в Google — 3–4 слова. Мы экономим слова, не объясняем, кому и зачем нужен «лучший смартфон» — рассчитываем, что алгоритм сам догадается.

В диалоговом ИИ все наоборот: от нас ждут задачи с контекстом, а не голых ключей.

ChatGPT: «Я ищу смартфон в бюджете до 50 000 рублей. Важно: хорошая камера для съемки видео, длительное время работы от батареи и чтобы он работал минимум 3–4 года без тормозов. Какие модели посоветуешь и почему?»

Вместо 3 слов — развернутое объяснение задачи. Исследования показывают, что средний промпт к ChatGPT — около 23 слов, то есть почти в 7 раз длиннее типичного Google-запроса.

Отдельное исследование Nectiv на промптах показывает тот же тренд: внутренние поисковые запросы ChatGPT примерно на 77% длиннее, чем обычные Google-запросы (5,48 слова против 3,4), и 77% запросов содержат 5+ слов.

Коротко: вместо ключевое слово и списка ссылок мы получаем описание задачи и уже целевой ответ под наш контекст.

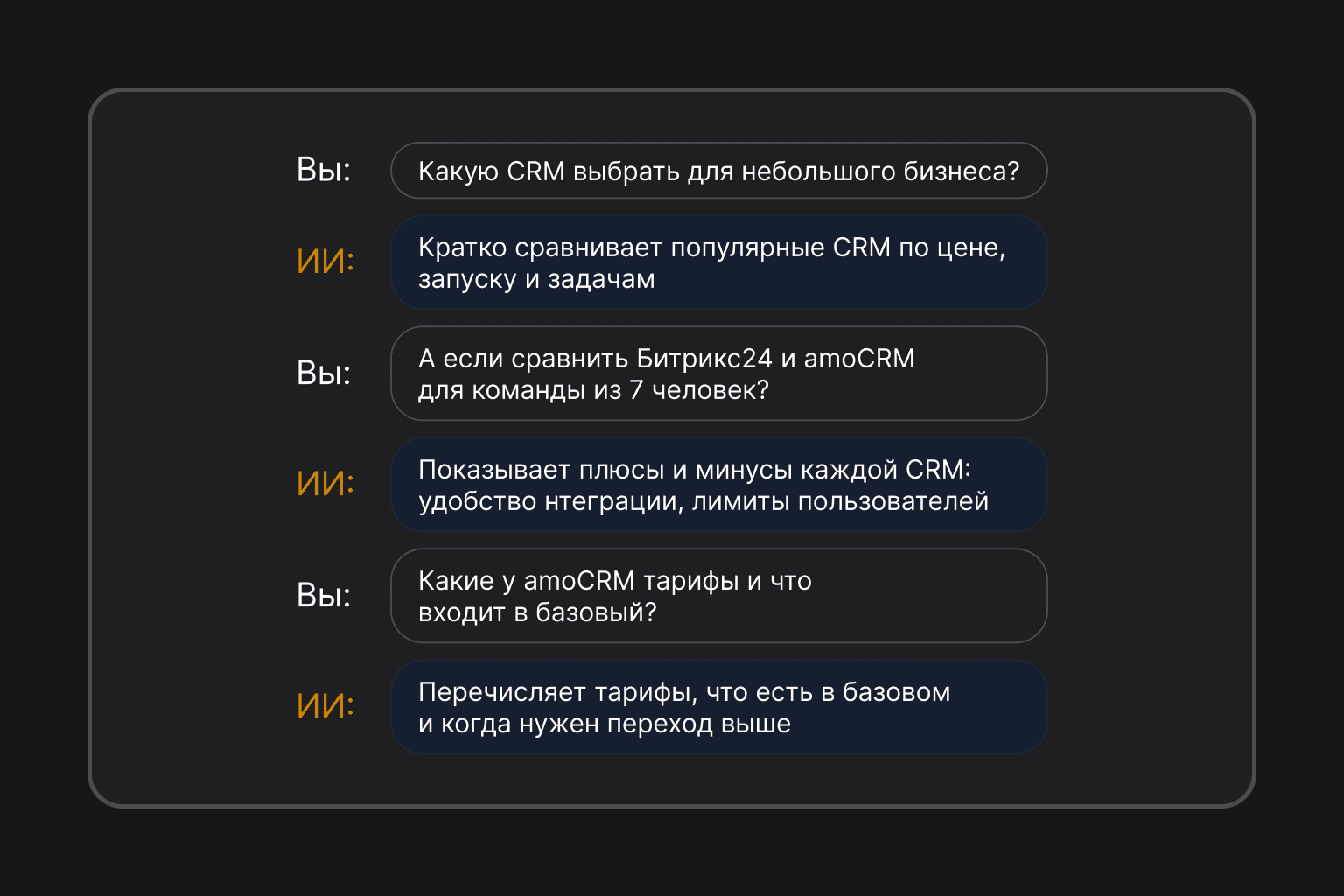

От пяти разных поисков к одному диалогу

Раньше, чтобы выбрать CRM, вы, скорее всего, делали цепочку запросов:

- crm системы

- crm для малого бизнеса

- bitrix24 vs amocrm

- amocrm цена тарифы

- amocrm отзывы 2025

Каждый запрос — новая вкладка, новый поисковый запрос и новые клики. Любое уточнение — новый поиск с нуля.

В диалоге с ИИ тот же сценарий выглядит так:

Один диалог вместо 5-ти разных поисков и изучением страниц/статей. При этом, если правильно промптить, то контекст не теряется, уточнения не требуют нового запроса, а пользователь работает в одной вкладке.

Примеры того, как больше людей стало промптить вместо того, чтобы гуглить

Ниже — короткие “до/после”, где хорошо видно, как меняется стиль типичных запросов пользователей, в которых они решают бытовые задачи.

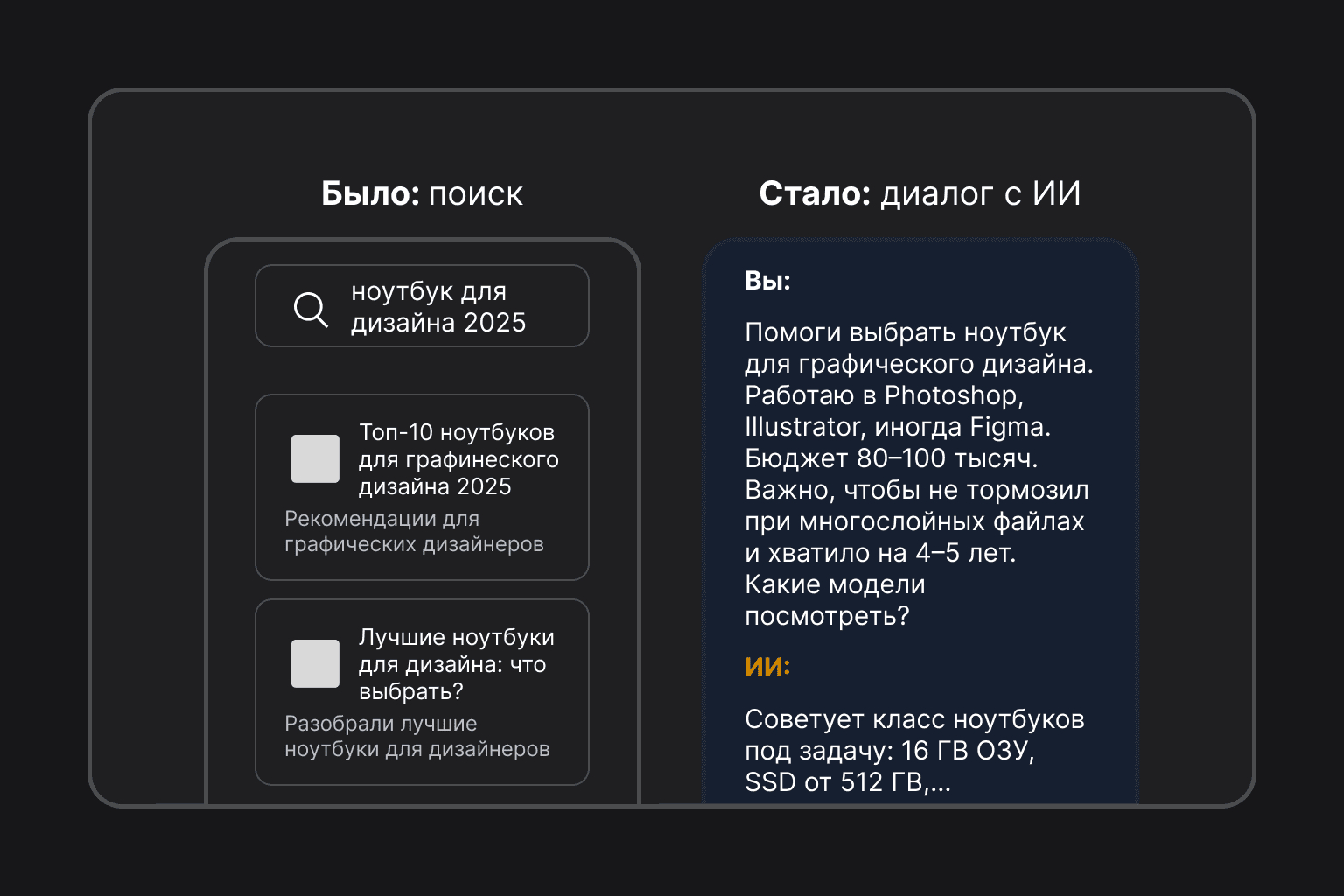

1. Покупка техники

И это лучше тем, что ИИшка понимает, чем вы занимаетесь и какая нагрузка, и дает рекомендацию под вашу задачу, а не ссылку на статью “Топ-10 ноутбуков 2025”.

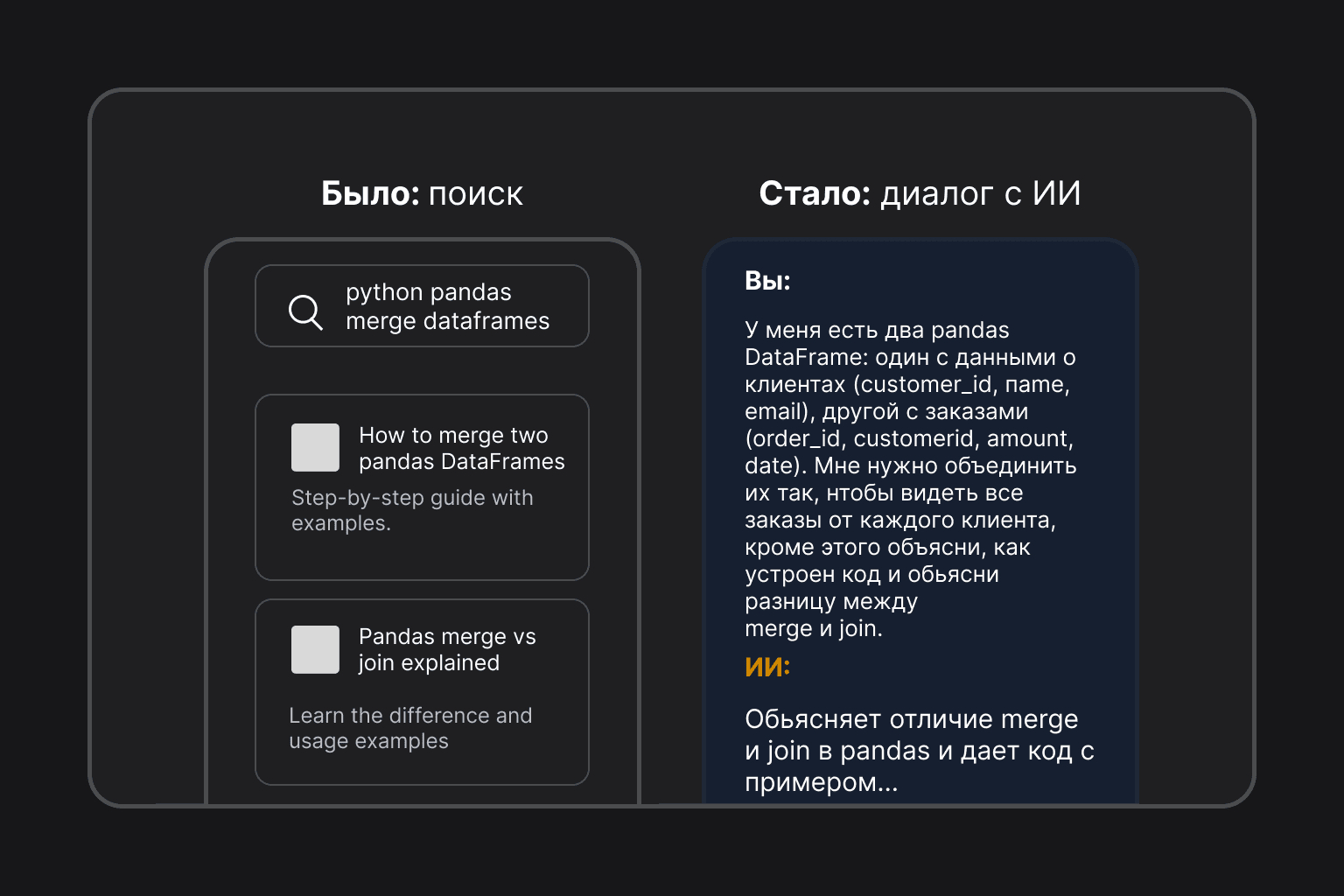

2. Решение технической задачи

Вместо чтения документации и тредов на Stack Overflow вы получаете готовый кусок кода под вашу схему данных плюс объяснение, как это работает.

Тут ИИшка учитывает повод (романтический ужин), бюджет и критерии (тихо, вино), а не просто выдает список всех итальянских ресторанов в радиусе.

3. Обучение новому

Шанс того, что вы получите объяснение под свой уровень, да еще и в двух версиях, а не обезличенную статью из Википедии или от онлайн-школы.

Главное отличие: появились генеративные задачи

То, чего не было в Google вообще: мы начали просить поиск что-то создать, а не только найти. Это новый класс запросов — генеративные.

Примеры генеративных промптов:

- Написание текстов. «Напиши email коллеге с просьбой перенести встречу на следующую неделю. Тон — дружелюбный, но профессиональный. Причина — накладка с другим важным митингом».

- Создание контент-плана. «Составь контент-план на месяц для Instagram салона красоты. Включи посты про услуги, отзывы клиентов, закулисье и образовательный контент».

- Переформулирование. «Перепиши этот текст более формально для отправки клиенту: "Привет! Мы тут подумали и решили, что цену надо поднять на 15%..."».

- Работа с ролями. «Представь, что ты опытный рекрутер. Я дам описание вакансии, а ты предложи стратегию поиска кандидатов и составь текст объявления».

Для Google такие запросы бессмысленны: он умеет доставать документы, но не умеет писать за вас письмо или план. Для ChatGPT это базовый сценарий.

По данным Profound Analytics, 37,5% запросов к ChatGPT уже относятся к генеративным (тексты, код, советы), еще ~32,7% — информационные. Навигационные запросы (типа “открой сайт X”) занимают около 2%.. Пользователи приходят к ИИ не за ссылками, а за результатом: готовым текстом, решением, рекомендацией.

Отсюда вытекает главный конфликт статьи:чем больше задач мы отдаем нейронкам, тем меньше прямых кликов получают сайты. И тем важнее становится вопрос: как сделать так, чтобы, когда ИИ отвечает, он опирался на ваш контент и называл ваш бренд?

Зачем бизнесу вообще думать про выдачу в ИИ

Чем больше задач мы отдаем нейросетям, тем меньше прямых кликов остается сайтам. Пользователь пришел в ChatGPT или Google SGE не за ссылками, а за готовым ответом — и часто уходит, так и не открыв ни один сайт.

Исследования SparkToro и Similarweb это подтверждают: почти 60% запросов в Google уже не приводят к переходу на сайты, а с запуском AI-ответов доля zero-click подросла до ~69% для части запросов. Параллельно Seer Interactive показывает: если над выдачей висит AI Overview, CTR первой позиции в органике падает более чем вдвое, с ~1,41% до ~0,61%.

Бороться только за “позицию в топ-3” становится бессмысленно: вы можете быть первыми и не получать трафика, если ответит за вас ИИ.

Отсюда логичный вопрос: как сделать так, чтобы, когда пользователь спрашивает у ChatGPT или Google, модель опиралась на ваш контент и называла ваш бренд? Это задача GEO.

Что такое GEO простыми словами

GEO (Generative Engine Optimization) — это оптимизация под генеративные поисковые движки и ассистентов: ChatGPT, Gemini, Perplexity, Google AI Overviews и т.д.

Если SEO отвечает на вопрос:

“Как выйти в топ-10 Google по запросу X?”,

то GEO отвечает на вопрос:

“Как сделать так, чтобы ИИ взял мой контент в основу ответа на запрос X и, по возможности, сослался на меня?”

ИИ, по сути, делает три шага:

- Берет результаты обычного поиска (те же топ-20 Google).

- Выбирает из них страницы, которые лучше всего подходят под формат ответа.

- Достает оттуда цифры, факты и формулировки и склеивает свой ответ.

Ваша задача — попасть в эту воронку:

- сначала — в топ органики (классический SEO никто не отменял);

- затем — сделать контент удобным для ИИ: структурированным, фактурным, похожим на хороший ответ.

Какие сигналы важнее всего для GEO

Если сильно упростить то, получается такой список приоритетов:

1. Авторитет домена и ссылки.

Сайты с большим количеством качественных referring domains и высоким trust score заметно чаще цитируются в AI-ответах. Для ChatGPT и SGE это по-прежнему основной фильтр: кому вообще можно доверять.

2. Content–Answer Fit — насколько текст уже похож на ответ.

Исследования на десятках тысяч страниц показывают: “соответствие ответу” объясняет до ~55% того, будет ли страница процитирована. Если у вас четкий разбор вопроса с заголовками, списками и явными выводами — вы в плюсе. Если “вода на 3000 слов” — ИИ найдет кого-то другого.

3. Глубина и фактура: длина, цифры, цитаты.

Длинные, но по делу тексты выигрывают. Страницы с 2900+ слов и насыщенные фактами/статистикой получают больше цитирований, чем короткие заметки. Отдельные работы показывают: наличие 19+ числовых данных и экспертных цитат сильно увеличивает шансы попасть в ответ.

4. Структура и разметка.

Нормальные подзаголовки, FAQ-блоки, таблицы, schema.org — все это облегчает жизнь и поиску, и моделям. В экспериментах страницы с качественной schema чаще попадали в AI Overviews Google, чем такие же страницы без разметки.

5. Отсутствие keyword stuffing.

Переспам по ключам в AI-поиске не помогает, а мешает: в отдельных тестах keyword stuffing снижал видимость контента примерно на 10%. LLM понимают смысл и тон, им не нужно по 20 повторений одного и того же слова.

Цифры и исследования: что реально меняется в поведении пользователя с приходом ИИ

Для тех, кому не хватило данных – подведем итоги фактурой. За последние два года появилось множество исследований о том, как AI влияет на поиск. Собрали самые показательные факты:

1. Запросы правда стали длиннее и разговорнее.

Как уже отмечали в статье выше, средняя длина промпта к ChatGPT ~23 слова против ~3–4 слов в веб-поиске. По данным Nectiv, 77% запросов к ChatGPT (когда он ищет сам) содержат ≥5 слов. В то же время, в Google тоже растет доля длинных “разговорных” запросов. Пользователи все меньше стесняются описывать проблему, а не бить по ключевикам.

2. Взамен переходов на сайт пользователь предпочитает резюме от ИИ.

В исследованиях conversational search (например, CHI 2024) пользователи с диалоговым поиском пишут более развернуто и при этом предпочитают краткое AI-резюме оригинальным статьям[16][17]. Они активнее дают боту обратную связь (лайки, дизлайки, уточнения), но возникает побочный эффект: LLM-поиск усиливает confirmatory search — модели подтверждают исходную позицию пользователя, усиливая поляризацию мнений.

3. Google все еще жив, но выдача постепенно мутирует.

Пока и близко никакой «смертью Google» не пахнет. Цифры показывают, что доля поиска держится около 92%, общий объем запросов растет. Меняется другое: все больше кликов остается внутри экосистемы Google (YouTube, Карты и т.д.), а часть вопросов вообще закрывается AI-ответом прямо в выдаче, который уже появляется в ~11% запросов. Пользователь получает саммари, переформулирует вопрос — и идет дальше, не открывая сайты.

4. ИИ-поиск перестал быть игрушкой гиков.

По оценкам Statista, за 7 месяцев weekly active users ChatGPT выросли примерно с 400 млн до 800 млн; сервис обрабатывает 2+ млрд запросов в день. Другие опросы показывают: доля взрослых, когда-либо использовавших ChatGPT, выросла с 18% до 34%, среди молодежи цифры еще выше; использование на работе выросло с 8% до 28%. Forrester добавляет корпоративный слой: 89% B2B-decision makers так или иначе экспериментируют с generative AI, средний бюджет — около $1,9 млн в год. То есть ваш пользователь с высокой вероятностью уже живет в мире ИИ-поиска.

5. С доверием к ИИ-ответам все еще не так однозначно.

Опросы показывают смешанную картину: около 25% пользователей считают AI-ответы более специфичными под их запрос, но лишь ~12% — более надежными, чем обычная выдача; 16% прямо не доверяют AI-результатам. Ссылки на источники повышают доверие примерно у 65% людей, но реально по ним переходит только ~27%. При этом исследования conversational search (уровня CHI 2024) отмечают: пользователи любят краткое AI-резюме и дают ему лайки/дизлайки, а побочный эффект — confirmatory search: модель подстраивается под уже имеющееся мнение, и человек уходит из чата еще более уверенным в себе.

Практический чек-лист: как использовать GEO с пользой для своего бизнеса

Для тех, кто хочет использовать ИИ в пользу для своего продукта, трафика и продаж – подготовили чек-лист, который можно разложить на задачи для команды.

1. Прокачайте AI-навыки внутри команды

Если маркетинг, саппорт и продакты сами редко пользуются ассистентами, GEO останется теорией.

- Соберите короткий внутренний гайд: 1–2 страницы с примерами промптов именно под ваши задачи (ответы в саппорте, продуктовые решения, подготовка релизов, техдоки).

- Попросите команду хотя бы неделю сознательно «делегировать» ИИ часть своих задач — чтобы руками почувствовать, какие ответы удобно читать, а какие нет.

- Разбирайте то, какие промпты дали лучший результат. Это же паттерны, под которые потом будет удобно затачивать контент.

2. Кроме семантического ядра соберите — ядро вопросов к ИИ

С ключами для SEO вы уже знакомы. В GEO мы работаем с вопросами и сценариями:

- Пройдитесь по ChatGPT, Perplexity, Gemini / ЯндексGPT с головой пользователя: «как выбрать X», «альтернатива Y», «что делать, если Z».

- Выпишите реальные формулировки вопросов. Не «CRM малый бизнес», а «какую CRM взять небольшой команде, если…».

- Напротив каждого вопроса честно поставьте: есть ли у нас страница, которая на это отвечает лучше конкурентов? Если нет — это приоритетные темы под контент.

3. Переделайте ключевые страницы под формат ответа

Модели любят страницы, которые уже выглядят как аккуратный ответ.

- Начните с короткого ответа: первые 2–3 предложения страницы должны сразу давать суть — кому это подходит, какую задачу решает, чем отличается от альтернатив.

- Разбейте текст на блоки-вопросы: H2/H3 в формате «Когда наш продукт подходит», «Кому лучше выбрать альтернативу», «Как мигрировать без боли».

- Все, что пользователь мог бы свернуть в список или таблицу (сравнение тарифов, плюсы/минусы, шаги настройки), сделайте списком или таблицей. Это то, что ИИ любит цитировать.

4. Добавьте фактуру: цифры, кейсы, опыт, а не пересказ чужих статей

Мы в GEO видим одну и ту же историю: страницы, наполненные водой модели игнорируют, а со страниц с конкретикой — подтягивают ответы.

- Вставляйте реальные цифры: конверсии, сроки внедрения, рост/падение метрик, диапазоны, а не «существенно выросло».

- Разберите 2–3 кейса по схеме: «было — что сделали — что стало» с нюансами, а не просто «увеличили на 30%».

- Добавьте голос эксперта: цитату СТО, тимлида, аналитика. Для пользователя это доверие, для модели — сигнал, что текст не переписан с чужого блога.

5. Приведите технику и разметку в порядок

Это скучная часть, но без нее вас могут просто не увидеть, как в SEO, так и в GEO.

- Убедитесь, что основной контент есть в HTML сразу, а не появляется только после горы JS. LLM не будут эмулировать ваш фронтенд.

- Расставьте нормальные заголовки (H1–H3), FAQ-блоки и HowTo-разделы.

- Добавьте schema.org (FAQ, Article, Product и т.д.) там, где это логично. Это помогает Google AI Overviews и остальным системам точнее вытаскивать куски текста.

- Проверьте robots.txt и всякие LLMs.txt: вы случайно не запретили скрапить ключевые разделы?

Это тот случай, где хорошая база по техничке в SEO даст хороший фундамент для GEO.

6. Сделайте дружественные для ИИ версии ключевых материалов

Поможем ассистентам чуть-чуть срезать углы.

- Для важных статей сделайте короткий блок с краткими ответами в начале. Пишите его так, будто уже отвечаете в ИИ-чате.

- На основе текста попросите ассистента составить 5–7 вопросов, на которые статья отвечает, и оформите их в отдельный FAQ.

- Для сравнений и обзоров добавьте компактные таблицы: «решение — для кого — плюсы — ограничения». Часто модели просто копируют такие таблицы в ответ.

Это улучшает жизнь и людям (быстрый скан), и моделям (готовые куски под цитату).

7. Выйдите за рамки только своего сайта

Модели учатся не только на корпоративных блогах.

- Если вы и так пишете на Хабр, vc.ru, отраслевые медиа — линкуйте статьи между собой и на доки/лендинги, чтобы для моделей это выглядело как единое поле экспертизы, а не россыпь случайных текстов.

- Для видео и подкастов добавляйте нормальные транскрипты и таймкоды. Текстовая обвязка важнее красивой обложки.

- Отвечайте на вопросы там, где уже сидит ваша аудитория (форумы, GitHub Discussions, профильные чаты). Для LLM это те самые живые и понятные источники, на которые приятно опираться в ответах.

8. Регулярно проверяйте, что ИИ вообще про вас знает

Мониторинг AI-ассистентов — это новый бренд-мониторинг по типу того, что делают пиарщики для брендов.

- Заводите список ключевых запросов из вашей ниши: «лучший X для…», «альтернатива Y», «как решить Z».

- Раз в месяц прогоняйте их через ChatGPT, Perplexity, Google SGE и смотрите: — упоминается ли ваш бренд; — если да — что именно про вас пишут; — кого еще советуют рядом.

- Если видите фактические ошибки или откровенный бред — проверьте, нет ли такого же мусора в публичных источниках (старые лендинги, заброшенные страницы, устаревшие прайс-листы).

- Когда ручного мониторинга станет много, можно подключить инструменты, которые отслеживают видимость бренда в AI-поиске автоматически: от классических SEO-платформ до специализированных решений. В том числе — сервисы вроде AI Semantica, которые показывают, по каким запросам и как часто ассистенты ссылаются на ваш сайт и конкурентов.