ТОП-15 Нейросетей для создания реалистичных видео: Как сделать короткий ролик с помощью ИИ

Как сделать реалистичное видео с помощью ИИ? Глубокий разбор инструментов: Veo 3, Sora 2, Kling 2.6, Runway 4 и других. Подробный гайд по генерации видео по тексту, оживлению фото и настройкам камеры для 100% реализма в кадре.

В 2026 году нейросеть для создания реалистичных видео перестала быть игрушкой для гиков и превратилась в стандарт индустрии контента. Если вы ищете способ быстро сделать короткий ролик с помощью ИИ, то вы попали по адресу. Рынок генеративных моделей взорвался: от кинематографичного качества Sora 2 до невероятной физики Kling 2.6. Теперь генерация любых видео доступна каждому, кто умеет формулировать мысли в текст. Мы отсеяли маркетинговый шум и собрали только те инструменты, которые реально работают, держат кадр и понимают физику света. Разберем, какой ИИ для генерации видео лучше подходит для рекламы, а какой — для оживления семейных фото.

🚀 ТОП-5 нейросетей для генерации видео в 2026 году

🎬 Kling 2.6 — Абсолютный лидер по физике движений. Эта нейросеть для видео создает пугающе реалистичные сцены, где ткань одежды и волосы ведут себя как в жизни.

🧠 Sora 2 — Самый популярный ИИ для генерации роликов от OpenAI. Лучший выбор, если нужно создать видео по тексту и фото с высокой детализацией и сложными пролетами камеры, практически неотличимый от кино.

🎥 Veo 3.1 — Ответ Google на запросы профессионалов. Идеально интегрируется в рабочие процессы, поддерживает высокое разрешение и понимает длинные, контекстные промпты на русском языке для создания коротких видео.

🎨 Runway 4 — Эта ИИ для создания видео дает максимальный контроль над стилем, позволяя управлять кистью Motion Brush каждым пикселем.

🇷🇺 VideoGen — Качественная русская нейросеть для видео. Оптимальный выбор для новичков: простой интерфейс и отличные результаты при генерации из картинки.

Выбираем нейросеть для видео под свои цели

В 2026 году уже нельзя просто сказать "хочу сделать видео из текста". Важно понимать задачу, ведь универсальной "кнопки шедевр" пока не придумали, хотя мы близко. Разные движки заточены под разные сценарии использования.

Для соцсетей, Reels и TikTok

Если ваша цель — виральность, вам нужна динамика. Для создания коротких видео с помощью ИИ, которые залетают в рекомендации, лучше всего подходят Sora 2 и Kling 2.6. Они позволяют быстро менять стили, делать морфинг объектов и добавлять креативные переходы. Это идеальные инструменты, чтобы сделать клип с помощью ИИ за пару минут.

Для бизнеса, промо и презентаций

Здесь важна стабильность персонажа и четкость картинки. Kling 2.6 и Veo 3.1 — ваши фавориты. Они держат консистентность: лицо героя не "поплывет" на пятой секунде. Также стоит обратить внимание на HeyGen, если нужно создание видео из текста с говорящим аватаром для обучающих роликов.

Оживление архивов и работа с фото

Частый кейс — сделать видео из фото с музыкой или оживить старый снимок. Для простых задач подойдет Veo 3.1, но если вы хотите профессионально перенести движения (например, свои танцы) на фотографию, используйте специализированный Kling Motion Control. Это уже не просто генерация видео из фотографии, а полноценный мокап без костюма.

Ниже мы разобрали "под капотом" каждый инструмент. Это не просто список, а практический разбор того, какая нейросеть для создания реалистичных видео достойна вашего времени и денег.

Kling 2.6 — новейшая нейросеть для генерации реалистичных видео

Kling 2.6 (Kuaishou) — Китайский гигант, который в 2026 году задает планку качества. Если вы хотите создать видео из фото так, чтобы никто не поверил в его искусственное происхождение, вам сюда. Модель блестяще работает с анатомией и сложными текстурами (вода, огонь, шерсть), а также отлично справляется с генерацией видео по текстовому описанию. Kling стал одним из первых, кто интегрировал несколько видео-задач в единую архитектуру, что делает его универсальным инструментом.

✅ Возможности:

- Генерация роликов до 10 секунд в 1080p с частотой 30 кадров.

- Потрясающее понимание физики реального мира и сложных взаимодействий.

- Возможность сделать реалистичное видео с помощью ИИ, загрузив референсное изображение для контроля композиции.

- Продвинутая лицевая анимация и синхронизация губ (Lip Sync) для говорящих персонажей.

- Инструменты для трансформации, стилизации и даже "бесшовного" дорисовывания (inpainting) видео.

- Поддержка различных соотношений сторон, что удобно для соцсетей.

📑 Как создавать видео с помощью Kling 2.6:

Главный секрет — используйте структуру промпта "Субъект + Действие + Окружение + Детали камеры". Kling очень чувствителен к описанию освещения. Чтобы создание видео по тексту дало киношный результат, обязательно укажите "cinematic lighting, 35mm lens". Для новичков совет: начните с простых сцен, где один объект совершает одно действие. Например, "рыжий кот пьет молоко из блюдца на деревянном полу, утренний свет из окна". Так вы быстрее поймете логику нейросети и сможете постепенно усложнять запросы.

🔗 Перейти на сайт нейросети Kling 2.6

Sora 2 — лучший ии для создания видео кинематографического уровня

Sora 2 — Флагман от OpenAI, который перевернул игру. Это мощнейшая нейросеть для видео, способная генерировать сложные сцены с множеством персонажей и точным следованием сценарию. Она понимает причинно-следственные связи в кадре лучше конкурентов, создавая не просто движение, а осмысленное действие. Sora может генерировать видео как по текстовому описанию, так и на основе загруженного изображения, предлагая беспрецедентный реализм.

✅ Возможности:

- Длительность генерации до 1 минуты в одном дубле (в Pro режиме).

- Идеальная консистентность объектов и персонажей при движении камеры.

- Лучший генератор видео по тексту для создания сложных сюжетных микро-фильмов.

- Создание видео в различных стилях: от фотореализма до анимации и сюрреализма.

- Автоматическое добавление звуковых эффектов и музыки, подходящих к сцене.

- Возможность "ремиксовать" чужие творения, заменяя персонажей или изменяя стиль.

📑 Как создавать видео с помощью Sora 2:

Sora любит подробные истории. Не пишите "кошка бежит". Пишите мини-рассказ: "Пушистая трехцветная кошка бежит по мокрой брусчатке Парижа на рассвете, отражения в лужах, камера летит низко". Чем больше контекста, тем круче этот ии для генерации видео отработает задачу. Полезный совет для начинающих: разбейте вашу идею на несколько ключевых сцен, как в раскадровке. Сгенерируйте каждую сцену отдельно, а потом соедините их в любом видеоредакторе. Это даст вам больше контроля над финальным результатом.

🔗 Перейти на сайт нейросети Sora 2

Veo 3.1 — передовая нейросеть для коротких видео от Google

Veo 3.1 — Инструмент для тех, кому важна интеграция и скорость. Эта модель отлично справляется с задачей создание видео по тексту и фото, предлагая высочайшее разрешение 4K. Veo понимает нюансы операторской работы, такие как "dolly zoom" или "pan right", что позволяет создавать ролики с профессиональной динамикой камеры. Модель также способна генерировать и синхронизировать звук с видео, что оживляет создаваемые сцены.

✅ Возможности:

- Поддержка разрешения 4K и различных соотношений сторон (портретное и ландшафтное).

- Продвинутый режим "Video FX" для стилизации.

- Отлично понимает команды по управлению камерой и кинематографические термины.

- Генерация видео со звуком, соответствующим происходящему в кадре.

- Быстрая версия Veo 3 Fast, оптимизированная для скоростной генерации контента.

- Возможность расширять существующие клипы и создавать плавные переходы.

📑 Как создавать видео с помощью Veo 3.1:

Используйте терминологию кинооператоров. Veo обучен на огромном массиве данных YouTube и понимает профессиональный сленг. Если вам нужно сделать видео из текста, похожее на документалку, добавьте "handheld camera movement" для эффекта присутствия. Совет для новичков: начните с простых команд камеры. Попробуйте запросы вроде "a drone shot flying over a forest" (пролет дрона над лесом) или "a close-up shot of a bee on a flower" (крупный план пчелы на цветке), чтобы увидеть, как Veo интерпретирует разные ракурсы.

🔗 Перейти на сайт нейросети Veo 3.1

Runway 4 — генерация реалистичных роликов

Runway 4 — Это не просто генератор, это целая студия. Если вас интересует обработка видео с помощью ии или полный контроль над происходящим в кадре, Runway нет равных. Их инструменты Motion Brush позволяют "красить" области, которые должны двигаться, давая вам точечный контроль над анимацией. Runway постоянно развивается, предлагая все новые и новые инструменты для креативщиков.

✅ Возможности:

- Уникальные инструменты контроля движения (Motion Brush, Camera Control).

- Высокая скорость рендеринга.

- Возможность сделать видео из фото с музыкой (синхронизация ритма).

- Генерация видео по тексту (Text-to-Video) и по изображению (Image-to-Video).

- Режим "Video-to-Video" для стилизации уже существующих роликов.

- Инструменты для удаления объектов из видео и расширения кадра (Inpainting & Outpainting).

📑 Как создавать видео с помощью Runway 4:

Не полагайтесь только на промпт. Загружайте исходное изображение и используйте "кисти движения". Выделите облака, чтобы они плыли, или воду, чтобы она текла. Это лучшая нейросеть для создания видео из фото с точечным управлением анимацией. Практический совет: для начала возьмите простую фотографию пейзажа. Попробуйте анимировать только один элемент — например, реку. Это поможет вам освоить Motion Brush, не перегружая сцену лишними движениями, и добиться чистого, реалистичного результата.

🔗 Перейти на сайт нейросети Runway 4

Kling Motion Control — ИИ для генерации видео из фотографии с переносом движений

Kling Motion Control — Узкоспециализированный, но невероятно мощный модуль. Он решает конкретную задачу: перенос движения с референсного видео на ваше фото. Это лучшая нейросеть для видео, если вы хотите "заставить" статичную модель танцевать или говорить, точно копируя движения с другого ролика. Технология анализирует позу, жесты и мимику, чтобы добиться максимально реалистичного переноса.

✅ Возможности:

- Точный перенос мимики и жестов (Motion Transfer).

- Работа со сложными скелетными анимациями.

- Идеально для создания вирусных роликов из мемов.

- Анализ формы тела и позы для более точного результата.

- Поддержка сложных движений и движений камеры.

- Возможность выбора между ориентацией персонажа по видео или по исходному изображению.

📑 Как создавать видео с помощью Kling Motion:

Загружайте видео-референс с четким силуэтом (лучше на однотонном фоне) и целевое фото. Следите, чтобы пропорции тела на видео и фото совпадали, тогда создание видео из фото пройдет без артефактов и искажений конечностей. Совет для новичков: для первых тестов используйте видео, где человек снят в полный рост и делает простые движения — машет рукой или приседает. В качестве фото возьмите изображение человека, стоящего прямо. Так вы минимизируете ошибки и лучше поймете, как работает технология.

🔗 Перейти на сайт Kling Motion Control

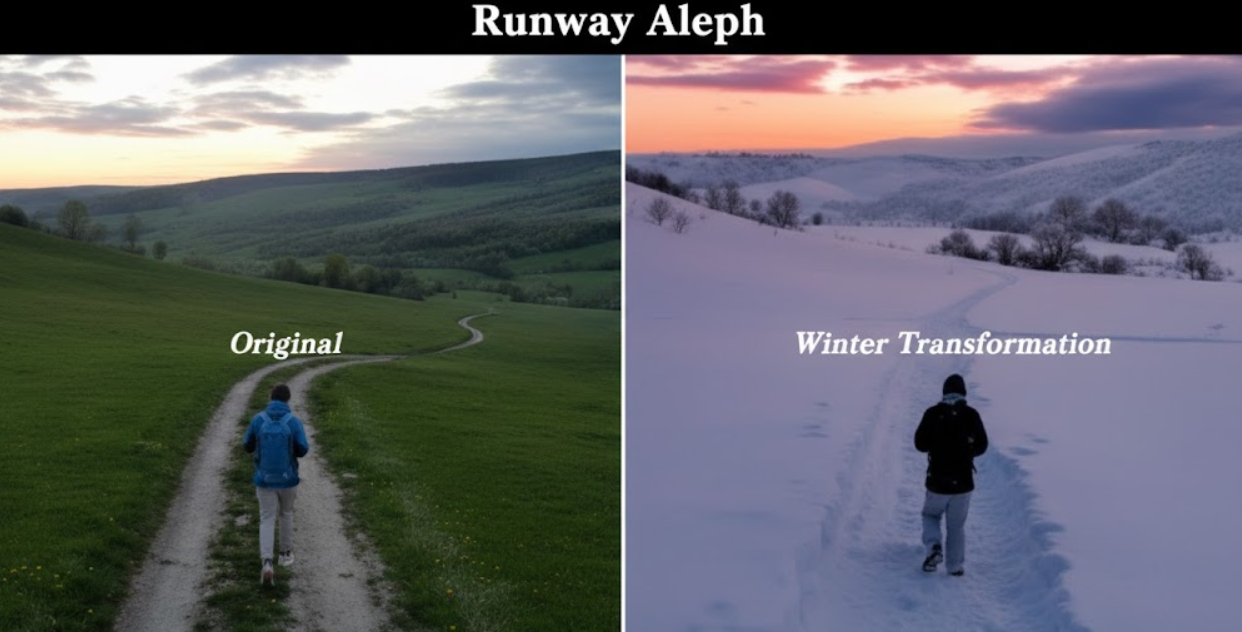

Runway Aleph — нейросеть изменяющая видео (трансформация)

Runway Aleph — Новейший алгоритм для глубокой трансформации. Это именно та нейросеть для монтажа видео, которая может превратить ролик, снятый на телефон во дворе, в киберпанк-боевик. Работает по принципу Video-to-Video, то есть берет ваше видео за основу и полностью меняет его стиль в соответствии с текстовым запросом или референсным изображением. Это открывает безграничные возможности для пост-продакшена и создания уникальных визуальных эффектов.

✅ Возможности:

- Полная стилизация видеоряда.

- Замена объектов в видео (Inpainting).

- Высокая стабильность кадров при изменении стиля.

- Применение стилей с картинки на все видео.

- Изменение окружения при сохранении движений актеров.

- Создание сложных визуальных эффектов без специального софта.

📑 Как создавать видео с помощью Aleph:

Используйте параметр "Denoising Strength" аккуратно. Если поставить слишком много — потеряете исходную суть видео. Если мало — стиль не применится. Aleph — это мощный ии для монтажа видео, требующий баланса настроек. Практический совет: начните с низких значений (0.3-0.4) и постепенно увеличивайте, пока не добьетесь нужного эффекта. Для кардинальной смены стиля лучше всего подходят видео с хорошим освещением и четкими объектами, так нейросети будет проще "зацепиться" за формы.

🔗 Перейти на сайт нейросети Runway Aleph

VideoGen — доступная русская нейросеть для видео

VideoGen — Отличное решение для отечественного рынка. Это агрегатор мощностей, упакованный в понятный интерфейс. Если вам нужно создание видео из фото бесплатно (или недорого) и без необходимости обходить блокировки, это ваш выбор. Сервис стремится сделать процесс создания видео максимально простым и быстрым, позволяя генерировать ролики буквально в один клик.

✅ Возможности:

- Понимает запросы на русском языке.

- Интуитивная генерация видео по тексту.

- Хорошее качество для контента в социальные сети.

- Быстрое создание видео для тех, у кого нет времени на сложные настройки.

- Возможность генерации видео из изображений.

- Простой и понятный интерфейс, ориентированный на новичков.

📑 Как создавать видео с помощью VideoGen:

Пишите запросы на родном языке. Модель отлично понимает культурный код и локальные контексты, чего часто лишены западные аналоги. Это самый простой способ создать видео по тексту бесплатно (в рамках триалов) для теста гипотез. Совет для начинающих: не бойтесь быть конкретными. Вместо "собака на пляже" напишите "джек-рассел-терьер ловит красный мячик на песчаном пляже у Черного моря". Чем точнее ваш запрос, тем интереснее будет результат.

Wan 2.5 — новая нейросеть для создания видео из фото

Wan 2.5 — Дерзкий новичок на рынке. Эта модель специализируется на коротких, но очень качественных лупах (цикличных видео). Если ищете бот для создания видео из текста с быстрой отдачей, Wan вас удивит. Он хорошо подходит для создания "живых фотографий" или синемаграфов, где движение минимально, но добавляет сцене атмосферы.

✅ Возможности:

- Высокая скорость генерации 5-секундных роликов.

- Отличная детализация лиц.

- Хорошо работает как генератор видео по тексту для абстрактных фонов.

- Создание плавных, зацикленных видео (лупов).

- Идеален для оживления статичных изображений.

- Простой интерфейс, не требующий сложных настроек.

📑 Как создавать видео с помощью Wan:

Wan лучше всего справляется с портретными планами и крупными деталями. Избегайте слишком общих планов с кучей мелких людей — там возможна каша. Идеально для "живых" аватарок. Практический совет: попробуйте загрузить фотографию своего портрета и напишите в промпте "слегка улыбается, волосы развеваются на ветру". Вы получите тонкую, но эффектную анимацию, которая отлично подойдет для профиля в соцсетях.

🔗 Перейти на сайт нейросети Wan

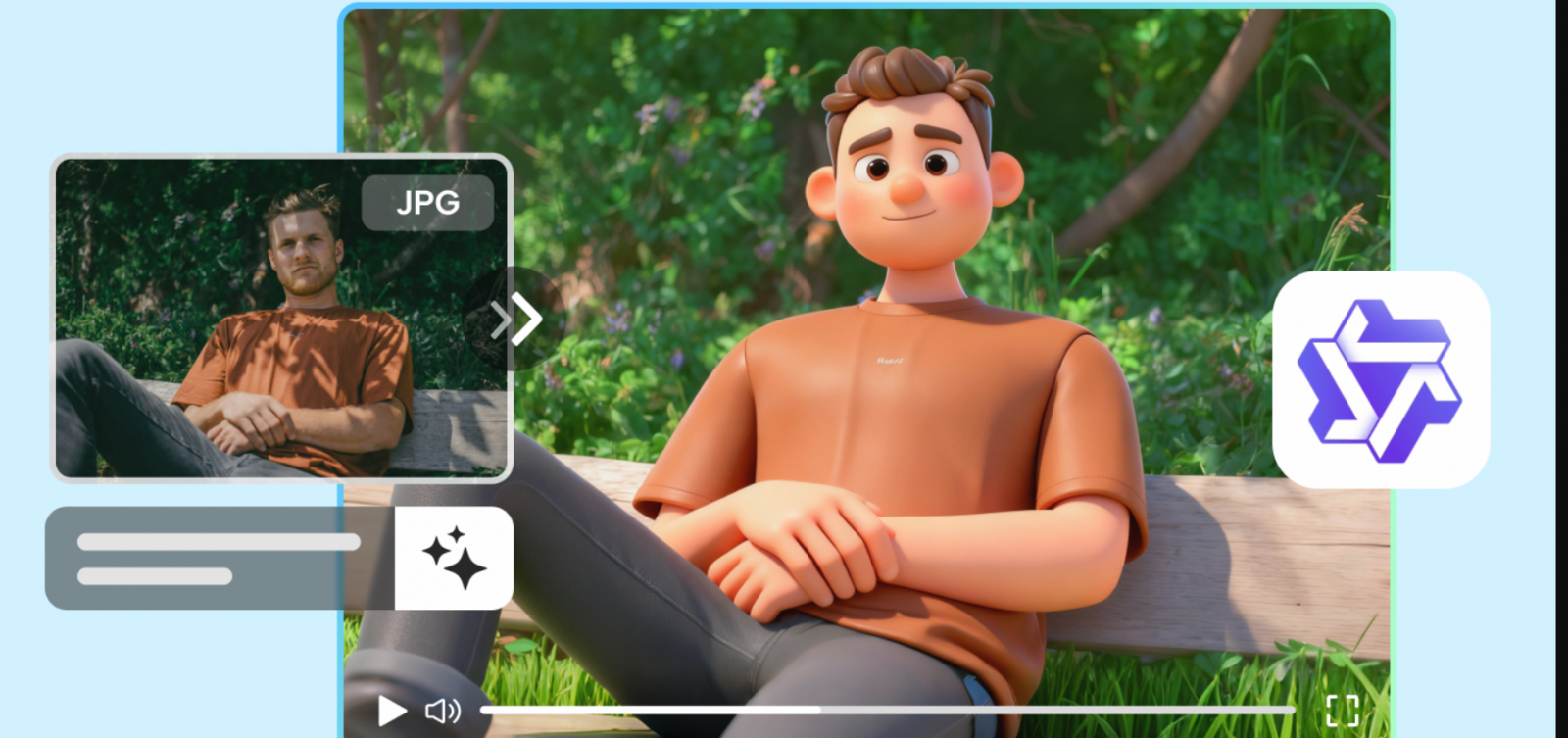

Pika — популярный бот для создания видео из текста и анимации

Pika — Старожил рынка, который не сдает позиций. Сейчас Pika — это комбайн с функциями Lip Sync (синхронизация губ). Если нужно сделать видео из текста, где персонаж говорит, Pika справится на отлично. Платформа постоянно обновляется, добавляя новые инструменты для редактирования и улучшения видео, что делает ее мощным решением для креаторов.

✅ Возможности:

- Функция Lip Sync (озвучка персонажей).

- Редактирование видео: изменение одежды, объектов.

- Удобная генерация видео из текста онлайн через веб-интерфейс и Discord.

- Расширение холста видео (Expand Canvas) для изменения соотношения сторон.

- Инструмент "Modify Region" для точечного изменения областей в кадре.

- Возможность загрузить свое видео и изменить его стиль (Video-to-Video).

📑 Как создавать видео с помощью Pika:

Используйте функцию "Modify Region". Выделите, например, очки на лице персонажа и напишите промпт "sunglasses". Pika заменит только этот элемент. Это отличная бесплатная нейросеть для монтажа (с ограничениями) мелких деталей. Совет для новичков: начните с функции "Text-to-Video". Сгенерируйте короткий ролик, а затем попробуйте его улучшить: расширьте холст, чтобы сделать его вертикальным для сторис, и измените один из объектов с помощью "Modify Region". Это научит вас многоступенчатой работе с видео.

🔗 Перейти на сайт нейросети Pika

Veed.io — платформа для обработки видео

Veed.io — Это полноценный видеоредактор, в который встроили ИИ для создания роликов. Здесь генерация — лишь часть процесса. Вы можете сразу наложить субтитры, обрезать и склеить. Платформа использует мощности ведущих AI-моделей и предлагает полный набор инструментов для редактирования, от обрезки до добавления B-roll.

✅ Возможности:

- Встроенный редактор + генератор.

- Автоматические субтитры и их перевод.

- Библиотека стоковых ассетов (видео, музыка).

- Инструмент для автоматического удаления пауз и неудачных дублей (Magic Cut).

- Создание видео из текста с помощью AI-аватаров.

- AI-инструмент для коррекции взгляда, чтобы вы всегда смотрели в камеру.

📑 Как создавать видео с помощью Veed:

Используйте Veed как финишную прямую. Сгенерируйте кадры в Kling или Sora, а сюда идите собирать ролик. Их инструмент "Magic Cut" сам удалит тишину и неудачные дубли, что сильно ускоряет создание видео на русском для блогов. Совет для начинающих: попробуйте сгенерировать короткое видео по текстовому промпту прямо в Veed, а затем используйте встроенный редактор, чтобы добавить к нему музыку из библиотеки и автоматические субтитры. Это самый быстрый способ получить готовый для публикации ролик.

Hailuo AI (Minimax) — азиатская нейросеть для коротких видео

Hailuo AI — Модель от Minimax, которая набирает популярность благодаря своей "мультяшности" и стилизации. Если нужен ии видео по тексту бесплатно (в бета-периодах) с уклоном в аниме или 3D-рендер, попробуйте её. Она отлично подходит для создания креативного контента, где фотореализм не является главной целью, а важен уникальный художественный стиль.

✅ Возможности:

- Уникальные стили рендеринга (аниме, 3D, фэнтези).

- Высокая скорость работы.

- Генерация по тексту и изображению.

- Хорошее понимание художественных и абстрактных запросов.

- Простой и понятный интерфейс.

- Возможность создавать яркие и динамичные клипы для соцсетей.

📑 Как создавать видео с помощью Hailuo:

Экспериментируйте со стилями. Hailuo часто выдает неожиданно крутые результаты на абстрактных запросах, где другие модели пытаются уйти в фотореализм. Совет для новичков: попробуйте добавить в конец вашего промпта слова "in anime style" или "3D render". Сравните результаты. Это поможет вам понять сильные стороны Hailuo и научиться управлять стилем генерации для достижения нужного художественного эффекта.

Luma Dream Machine — быстрая генерация реалистичных видео

Luma Dream Machine — Очень быстрый и качественный генератор. Их фишка — бесплатный доступ к базовым функциям, что делает Luma отличной точкой входа для тех, кто хочет создать видео из фото бесплатно. Модель позволяет генерировать видео как из текста, так и из изображений, обеспечивая плавное и реалистичное движение.

✅ Возможности:

- Создание качественных первых и последних кадров (Keyframes).

- Высокая скорость генерации (120 кадров за 120 секунд).

- Генерация видео из текста и изображений.

- Создание кинематографичных и плавных движений камеры.

- Поддержка редактирования с помощью текстовых описаний.

- Сохранение стилистики и идентичности персонажа в разных сценах.

📑 Как создавать видео с помощью Luma:

Используйте функцию "End Frame". Загрузите начало и конец видео (две картинки), и Luma сгенерирует переход между ними. Это лучший способ сделать видео из фото с контролируемым сюжетом. Совет новичкам: начните с простого. Возьмите фото своего домашнего питомца, сидящего на диване. В качестве конечного кадра используйте то же фото, но немного отредактированное (например, сдвиньте игрушку рядом). Luma создаст короткое видео, где питомец "двигает" игрушку. Это отличная тренировка для понимания логики переходов.

🔗 Перейти на сайт Luma Dream Machine

HeyGen — лучшая нейросеть для создания видео с аватарами

HeyGen — Лидер в нише говорящих голов. Это не совсем про кино, это про бизнес. Если вам нужно создание видео из текста для корпоративного обучения или новостей, HeyGen незаменим. Платформа позволяет создавать реалистичные аватары, которые могут озвучивать любой текст с поразительной синхронизацией губ, экономя время и ресурсы на съемках.

✅ Возможности:

- Идеальный лип-синк (движение губ).

- Возможность создать своего цифрового двойника (Instant Avatar).

- Перевод видео на другие языки с сохранением голоса.

- Большая библиотека готовых аватаров и голосов.

- Шаблоны для разных типов видео (презентации, обучение, маркетинг).

- Интеграция с рабочими инструментами для автоматизации создания контента.

📑 Как создавать видео с помощью HeyGen:

Не используйте стандартные аватары, они приелись. Запишите 2 минуты себя на камеру, создайте "Instant Avatar" и генерируйте контент вечно. Это реальный способ масштабировать создание видео из текста для блога. Практический совет: при записи видео для создания аватара смотрите прямо в камеру, говорите четко и не делайте резких движений головой. Убедитесь, что фон однотонный, а освещение хорошее. Качество исходного видео напрямую влияет на реалистичность вашего цифрового двойника.

Synthesia — платформа для создания видео по тексту для бизнеса

Synthesia — Главный конкурент HeyGen. Строгий, корпоративный стиль. Если ваша задача — генерация видео из текста онлайн для презентации инвесторам, Synthesia даст нужный уровень серьезности. Платформа позволяет за несколько кликов превращать текст в профессиональные видеоролики с AI-аватарами, что идеально подходит для бизнеса и образовательных целей.

✅ Возможности:

- Огромная библиотека профессиональных аватаров.

- Встроенный редактор сценариев.

- Поддержка более 120 языков и акцентов.

- Возможность создавать собственные кастомные аватары.

- Интеграция с PowerPoint и другими инструментами для презентаций.

- Автоматическая генерация видео по тексту.

📑 Как создавать видео с помощью Synthesia:

Используйте встроенные шаблоны. Они сэкономят вам часы верстки. Просто вставьте текст, и программа для создания видео из фото и аватаров сделает все остальное. Совет для начинающих: перед генерацией всего видео прослушайте, как AI-голос произносит ваш текст. Обратите внимание на интонации и паузы. Иногда, чтобы речь звучала естественнее, нужно добавить знаки препинания (запятые, точки) или даже разбить длинное предложение на несколько коротких. Это сильно улучшит итоговое качество.

Stable Video Diffusion — open-source ии генерирует видео из текста

Stable Video — Выбор технарей. Модель от Stability AI, которую можно (при желании и мощном ПК) запустить локально. Это основа для многих сервисов, предлагающих сделать видео из текста. Модель является развитием популярной нейросети для генерации изображений Stable Diffusion и переносит ее возможности в область видео.

✅ Возможности:

- Гибкость и настраиваемость (при локальном использовании).

- Высокое качество генерации "Image-to-Video".

- Открытый исходный код, что позволяет энтузиастам создавать свои инструменты.

- Возможность генерировать короткие видеоклипы из одного изображения.

- Поддержка различных моделей и версий, включая улучшенные варианты.

- Активное сообщество, которое делится советами и готовыми решениями.

📑 Как создавать видео с помощью SVD:

Лучше всего использовать через веб-сервисы, если у вас нет мощной видеокарты. Модель отлично понимает глубину сцены, поэтому используйте её для оживления пейзажей и архитектуры. Совет для новичков: найдите в интернете сервисы, которые предоставляют интерфейс для Stable Video. Начните с функции "Image-to-Video". Загрузите красивую картинку пейзажа, сгенерированную другой нейросетью, и посмотрите, как SVD добавит в нее движение: полет камеры, движение облаков или рябь на воде.

🔗 Перейти на сайт Stable Video

Рынок меняется мгновенно. Еще вчера мы удивлялись "плавающим" лицам, а сегодня нейросеть делает видео из текста неотличимым от съемок на камеру. Выбирайте инструмент под задачу: Kling и Sora — для киношного качества, VideoGen и Pika — для соцсетей, HeyGen — для бизнеса. Начните с малого, и вы удивитесь, как легко теперь стать режиссером.

Полный гайд по созданию AI видео: От промпта до финального рендера

В 2026 году граница между "я ввел текст" и "я снял кино" окончательно стерлась. Но нейросети — это не магические шары, а мощные, но капризные вычислительные движки. Они не понимают намеков. Чтобы сделать реалистичное видео с помощью ИИ, вы должны стать режиссером, оператором и гафером (осветителем) в одном лице. Ваша задача — перевести визуальный образ из головы на язык токенов и параметров.

Ниже — детальный технический пайплайн, который актуален для топовых моделей: Sora 2, Kling 2.6, Veo 3.1 и Runway Gen-3.

Шаг 1: Анатомия идеального промпта (The 4C Model)

Главная ошибка новичков — абстракция. Фраза "красивый закат" для нейросети — это миллион вариантов, от аниме до документалистики BBC. Чтобы генерация видео по тексту была предсказуемой, используйте жесткую формулу 4C.

1. Context & Subject (Контекст и Герой)

Не просто "мужчина", а "усталый пожарный 40 лет, лицо испачкано сажей, тяжелое дыхание". Нейросеть должна знать фактуру. Указывайте материалы: "шелковая рубашка", "ржавый металл", "мокрый асфальт". Чем больше физических свойств вы опишете, тем реалистичнее нейросеть для создания видео просчитает отражения света.

2. Camera & Lens (Камера и Оптика)

Это самый важный блок для кинематографичности. ИИ обучался на фильмах, поэтому он понимает язык объективов:

- Wide angle / 16mm: Для пейзажей и масштабных сцен. Дает ощущение простора.

- Telephoto / 85mm или 100mm: Сжимает перспективу, размывает фон (боке), идеально для портретов.

- Macro shot: Для сверхкрупных деталей (глаз, капля воды, текстура ткани).

- GoPro / Fish-eye: Для динамики и эффекта присутствия.

3. Lighting & Atmosphere (Свет и Атмосфера)

Свет определяет настроение. Без описания света вы получите "плоскую" картинку, похожую на сток. Используйте профессиональные дескрипторы:

- Volumetric lighting: Объемные лучи света, проходящие через пыль или туман. Маст-хэв для эпичности.

- Cinematic Teal and Orange: Самая популярная цветовая схема в кино (холодные тени, теплый свет).

- Rembrandt lighting: Драматичный свет с тенью на половине лица.

- Bioluminescent: Неоновое, светящееся изнутри освещение (для фантастики).

4. Motion Description (Характер движения)

Описывайте не только что движется, но и как. Глаголы решают всё: "stumbles" (спотыкается) вместо "walks", "sprints" (спринтует) вместо "runs". Уточняйте скорость: "slow motion" (замедление) или "hyperlapse" (ускоренное течение времени).

Шаг 2: Продвинутое управление камерой (Camera Control)

Чтобы зритель поверил в происходящее, камера должна вести себя как физический объект, а не как летающая точка. В 2026 году лучшие ИИ для генерации видео различают движение объекта и движение камеры.

Базовые движения:

- Static Shot: Камера на штативе. Движется только герой. Это лучший способ избежать "галлюцинаций" фона. Используйте для диалогов.

- Pan & Tilt: Поворот камеры влево/вправо или наклон вверх/вниз. Имитирует взгляд человека, оглядывающегося по сторонам.

Сложные операторские приемы:

- Truck / Tracking Shot: Камера едет параллельно герою. Используйте это, чтобы сделать короткий ролик с идущим человеком, где фон меняется, а герой остается в фокусе.

- Orbit / Arc Shot: Камера облетает героя по кругу. Очень сложно для ИИ (часто меняется лицо), но выглядит эффектно в модельных съемках.

- Rack Focus: Смена фокуса. Сначала резким является цветок на переднем плане, затем фокус плавно переходит на девушку сзади. Это высший пилотаж промпт-инжиниринга.

Шаг 3: Технические параметры (скрытые настройки)

Многие пользователи игнорируют ползунки настроек, полагаясь на дефолт. Это ошибка. Именно здесь происходит тонкая настройка того, как нейросеть для видео интерпретирует ваши слова.

Creativity vs. Adherence (CFG Scale)

Параметр, отвечающий за "фантазию".Если вы ставите высокое значение (High Creativity), ИИ добавит детали, которых не было в промпте. Это хорошо для арт-хауса, но плохо для конкретных задач. Если вам нужно четко сделать видео по тексту (например, "красный мяч падает на траву"), снижайте креативность до минимума, чтобы ИИ не превратил мяч в воздушный шар.

Motion Bucket / Motion Scale (ID движения)

Этот параметр (актуален для SVD, Kling, Runway) определяет количество пикселей, которые изменятся за время ролика.Низкое значение (1-4): Идеально для портретов, рекламы ювелирки. Меньше артефактов, лицо остается стабильным.Высокое значение (8-10): Экшн, погони, взрывы. Будьте готовы к тому, что у людей могут появиться лишние конечности, так как ИИ сложнее просчитать траекторию.

Seed (Зерно генерации)

Уникальный цифровой код каждой генерации. Если вы создали идеальное видео, но хотите лишь немного изменить движение руки — сохраните номер Seed. Используя тот же промпт и тот же Seed, вы получите почти идентичный результат с минимальными правками. Без фиксации Seed каждая новая попытка — это лотерея.

Negative Prompt (Отрицательный промпт)

Это фильтр, отсекающий мусор. Для видео он критически важен. Стандартный набор для реализма должен включать не только "bad anatomy", но и специфические видео-артефакты: "morphing, flickering, jittering, static noise, watermark, distorted faces, melting bodies, cartoon style". Это заставляет нейросеть чистить кадры от характерного "дрожания".

Шаг 4: Стратегии для разных целей (Scenario Guide)

Подход к созданию контента кардинально отличается в зависимости от вашей конечной цели. Универсальных настроек не существует, но есть проверенные стратегии.

🎥 Для кинематографического реализма (Movie & Art)

Самый надежный путь здесь — не генерировать "из воздуха", а использовать связку Image-to-Video. Сначала создайте безупречный кадр в Midjourney v7, где идеально выставлен свет и композиция. Загрузите его в Kling 2.6 или Runway как первый кадр (First Frame). В промпте опишите минимальное движение: "subtle breathing, wind blowing smoothly, blinking". Чем меньше движения вы требуете от сложной сцены, тем реалистичнее она останется. Кино — это часто статика и атмосфера, а не беготня.

📱 Для вирусных роликов (Social Media & TikTok)

Здесь нужна агрессивная динамика и вау-эффект. Используйте Runway 4 с инструментом Motion Brush. Выделите объект, который должен двигаться неестественно или быстро (например, кот, который надувается как шар). Для соцсетей важна цикличность — попробуйте создавать "Loop video", где последний кадр совпадает с первым. Нейросети вроде Pika и Wan 2.5 отлично справляются с короткими, смешными анимациями, которые привлекают внимание за секунду.

👔 Для бизнес-презентаций и рекламы продуктов

Ваш приоритет — стабильность продукта. Если вы рекламируете кроссовки, они не должны менять форму и логотип в процессе видео. Используйте Google Veo 3.1 или Sora 2 с низким значением Motion Scale (3-4). Лучший операторский прием здесь — "Slow Pan" или "Product Rotation". Избегайте участия людей в кадре с рекламой товара, если это не цифровая аватара (как в HeyGen), так как мимика — самое слабое место при генерации с товаром.

Финальный чек-лист перед рендером:

- Проверка света: Указан ли источник освещения (softbox, sun, neon)?

- Тип камеры: Задана ли оптика (35mm, macro)?

- Движение: Есть ли конфликт между движением героя и камеры? (Лучше, чтобы двигалось что-то одно).

- Формат: Выбрано ли соотношение сторон 16:9 для YouTube или 9:16 для Reels? (Обрезать потом без потери качества сложно).

- Seed: Зафиксировали ли вы Seed, если планируете дорабатывать этот шот?